還未開放,Sora 怎麼就震驚了互聯網圈?

TechFlow Selected深潮精選

還未開放,Sora 怎麼就震驚了互聯網圈?

OpenAI 直接稱它為「世界模擬器」,能夠模擬物理世界中的人、動物和環境的特徵。

撰文:木沐

還未開放公眾測試,OpenAI 憑藉文本生成視頻模型 Sora 製作的預告片,就把科技圈、互聯網、社交媒體圈給震驚了。

根據 OpenAI 官方發佈的視頻,Sora 能夠根據用戶提供的文本信息,生成長達 1 分鐘的複雜場景「超視頻」,不僅畫面細節逼真,這個模型還會模擬鏡頭運動感。

從已釋出的視頻效果看,業內興奮的正是 Sora 體現出的理解真實世界的能力。相較其他文本到視頻的大模型,Sora 在對語義理解、畫面呈現、視覺連貫性和時長上都顯示出優勢。

OpenAI 直接稱它為「世界模擬器」,宣告它能夠模擬物理世界中的人、動物和環境的特徵。但該公司也承認,目前 Sora 的還不完美,依然存在理解不到位和潛在的安全問題。

因此,Sora 僅對非常少數的人開放測試,OpenAI 尚未公佈 Sora 何時會向大眾開放,但它帶來的震撼足以讓研發同類模型的公司看到差距。

Sora「預告片」驚爆眾人

OpenAI 文本生成視頻模型 Sora 一出,國內又現「震驚體」評價。

自媒體驚呼「現實不存在了」,互聯網大佬也吹爆了 Sora 的能力。360 創始人周鴻禕稱,Sora 的誕生意味著 AGI 的實現可能從 10 年縮短至兩年左右。短短几天,Sora 的谷歌搜索指數迅速拉昇,熱度直逼 ChatGPT。

Sora 的爆火源於 OpenAI 發佈的 48 段視頻,其中時長最長的為 1 分鐘。這不僅打破了此前文生視頻模型 Gen2、Runway 生成視頻的時長極限,而且畫面清晰,甚至它還學會了鏡頭語言。

1 分鐘視頻中,一位身著紅裙的女性走在霓虹燈林立的街頭,風格寫實,畫面流暢,最令人驚豔的是女主角的特寫,連臉部的毛孔、斑點、痘印都模擬了出來,卡粉脫妝效果堪比直播關掉美顏濾鏡,脖子上的頸紋甚至精準「洩露」了年齡,與臉部狀態做到了完美統一。

除了對人物寫實,Sora 還能夠模擬現實中的動物與環境。一段視頻維多利亞冠鴿的多角度特寫,超清呈現了這隻鳥全身至冠的藍色羽毛,甚至細微到紅色眼珠的動態和呼吸頻率,讓人很難分清這到底是 AI 生成的還是人類拍攝的。

對於非寫實的創意動畫,Sora 的生成效果也達到了迪士尼動畫電影的畫面感,讓網友擔憂起動畫師的飯碗。

而 Sora 為文本生成視頻模型帶來的改進不僅在視頻時長與畫面效果上,它還能模擬鏡頭與拍攝的運動軌跡,遊戲的第一人稱視角,航拍視角,甚至是電影裡的一鏡到底。

看完 OpenAI 放出的精彩視頻,你就能理解互聯網圈、社交媒體輿論為什麼會為 Sora 感到震驚,而這些只是預告片。

OpenAI 提出「視覺補丁」數據集

那麼,Sora 是如何實現模擬能力的?

按照 Open AI 發佈的 Sora 技術報告,這個模型正在超越先前圖像數據生成模型的限制。

以往的文本生成視覺畫面的研究採用過各種方法,包括循環網絡、生成對抗網絡(GAN)、自迴歸變換器和擴散模型,但共性是集中在較少的視覺數據類別、較短的視頻或固定尺寸的視頻上。

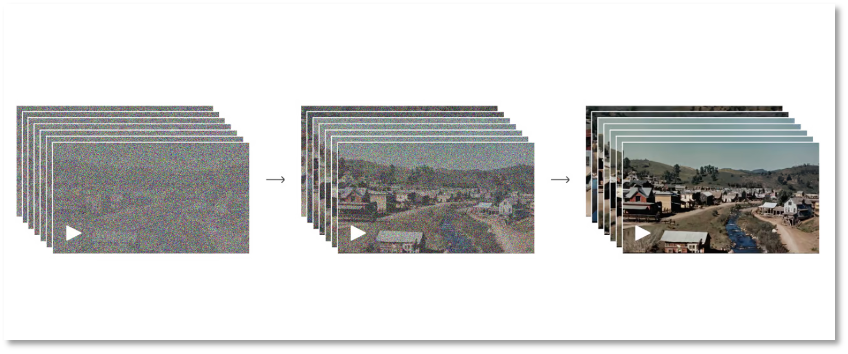

Sora 採用了一種基於 Transformer 的擴散模型,生圖過程可以分為正向過程和反向過程兩個階段,以實現 Sora 能沿時間線向前或向後擴展視頻的能力。

正向過程階段模擬了從真實圖像到純噪點圖像的擴散過程。具體來說,模型會逐步地向圖像中添加噪點,直到圖像完全變成噪點。而反向過程是正向過程的逆過程,模型會從噪點圖像逐步恢復出原始圖像。一正一反,虛實來回,OpenAI 以這種方式讓機器 Sora 理解視覺的形成。

從全噪點到清晰圖的過程

從全噪點到清晰圖的過程

當然,這個過程需要反覆地訓練學習,模型會學習如何逐步去除噪聲並恢復圖像的細節。通過這兩個階段的迭代,Sora 的擴散模型能夠生成高質量的圖像。這種模型在圖像生成、圖像編輯、超分辨率等領域表現出了優秀的性能。

上述過程解釋了 Sora 能做到高清、超細節的原因。但從靜態的圖像到動態的視頻,仍需要模型進一步積累數據,訓練學習。

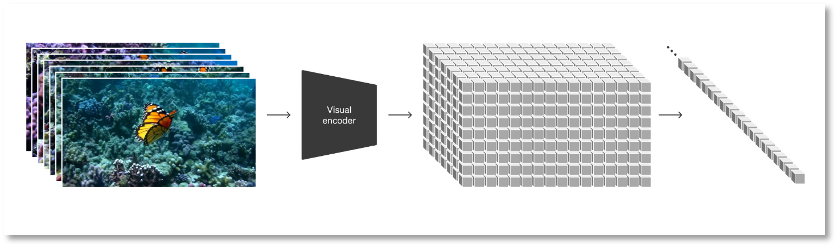

在擴散模型的基礎上,OpenAI 將視頻和圖像等所有類型的視覺數據轉換為統一表示,以此來對 Sora 做大規模的生成訓練。Sora 使用的表示方式被 OpenAI 定義為「視覺補丁(patches)」,即一種更小數據單元的集合,類似於 GPT 中的文本集合。

研究者首先將視頻壓縮到一個低維潛空間中,隨後把這種表徵分解為時空 patch,這是一種高度可擴展的表徵形式,方便實現從視頻到 patch 的轉換,也正適用於訓練處理多種類型視頻和圖片的生成模型。

將視覺數據轉化為 patches

將視覺數據轉化為 patches

為了用更少的信息與計算量訓練 Sora,OpenAI 開發了一個視頻壓縮網絡,把視頻先降維到像素級別的地低維潛空間,然後再去拿壓縮過的視頻數據去生成 patches,這樣就能使輸入的信息變少,從而減少計算壓力。同時,OpenAI 還訓練了相應的解碼器模型,將壓縮後的信息映射回像素空間。

基於視覺補丁的表示方式,研究者能對 Sora 針對不同分辨率、持續時間和長寬比的視頻 / 圖像進行訓練。進入推理階段,Sora 能通過在適當大小的網格中排列隨機初始化的 patches 來判斷視頻邏輯、控制生成視頻的大小。

OpenAI 報告,在大規模訓練時,視頻模型就表現出令人興奮的功能,包括 Sora 能夠真實模擬現實世界中的人、動物和環境,生成高保真的視頻,同時實現 3D 一致性、時間一致性,從而真實模擬物理世界。

Altman 當二傳手為網友測試

從結果到研發過程,Sora 顯示著強大的能力,但普通用戶還無從體驗,目前只能寫好提示詞,在 X 上@OpenAI 創始人 Sam Altman,由他作為二傳手,幫網友們在 Sora 上生成視頻後放出來給公眾看效果。

這也不免令人懷疑 Sora 是否真的如 OpenAI 官方展示得那麼牛。

對此,OpenAI 直言,目前模型還存在一些問題。如同早期的 GPT 一樣,現在的 Sora 也有「幻覺」,這種錯誤表示在以視覺為主的視頻結果上顯示地更為具象。

例如,它不能準確地模擬許多基本相互作用的物理過程,例如跑步機履帶與人的運動關係,玻璃杯破碎與杯內液體流出的時序邏輯等等。

在下面這個「考古工作者們挖掘出一個塑料椅」的視頻片段裡,塑料椅直接從沙子裡「飄」了出來。

還有憑空出現的小狼崽,被網友戲稱為「狼的有絲分裂」。

它有時也分不清前後左右。

這些動態畫面中存在的紕漏似乎都在證明,Sora 仍需要對物理世界運動的邏輯去做更多的理解和訓練。此外,相比 ChatGPT 的風險,給人直觀視覺體驗的 Sora 存在的道德、安全風險更甚。

此前,文生圖模型 Midjourney 已經告訴人類 「有圖不見得有真相」,人工智能生成的以假亂真的圖片開始成為謠言要素。身份驗證公司 iProov 的首席科學官紐維爾博士就表示,Sora 能讓「惡意行為者更容易生成高質量的假視頻。」

可想而知,如果 Sora 生成的視頻被惡意濫用,搞在欺詐和誹謗、傳播暴力和色情上,造成的後果也難以估量,這也是 Sora 讓人在震驚之餘還會害怕的原因。

OpenAI 也考慮到了 Sora 可能帶來的安全問題,這大概也是 Sora 僅對非常少數人以邀請制開放測試的原因。何時會大眾開放?OpenAI 沒有給出時間表,而從官方釋出的視頻看,其他公司追趕 Sora 模型的時間不多了。

歡迎加入深潮 TechFlow 官方社群

Telegram 訂閱群:https://t.me/TechFlowDaily

Twitter 官方帳號:https://x.com/TechFlowPost

Twitter 英文帳號:https://x.com/BlockFlow_News