Variant Nhà đầu tư đối tác: Bế tắc và đột phá của AI mã nguồn mở, tại sao công nghệ mã hóa là mảnh ghép cuối cùng?

Tuyển chọn TechFlowTuyển chọn TechFlow

Variant Nhà đầu tư đối tác: Bế tắc và đột phá của AI mã nguồn mở, tại sao công nghệ mã hóa là mảnh ghép cuối cùng?

Kết hợp AI mã nguồn mở với công nghệ mã hóa có thể hỗ trợ phát triển các mô hình quy mô lớn hơn, thúc đẩy nhiều đổi mới hơn và từ đó tạo ra các hệ thống AI tiên tiến hơn.

Tác giả: Daniel Barabander

Biên dịch: TechFlow

Tóm tắt ngắn gọn

-

Việc phát triển AI nền tảng hiện nay đang do một vài công ty công nghệ lớn chi phối, mang tính chất khép kín và thiếu cạnh tranh.

-

Mặc dù phần mềm mã nguồn mở là một giải pháp tiềm năng, nhưng AI nền tảng không thể hoạt động như các dự án mã nguồn mở truyền thống (ví dụ như Linux), vì nó đối mặt với “vấn đề tài nguyên”: các cộng sự viên mã nguồn mở không chỉ cần cống hiến thời gian mà còn phải gánh chi phí tính toán và dữ liệu vượt quá khả năng cá nhân.

-

Công nghệ mã hóa có thể giải quyết vấn đề tài nguyên này bằng cách tạo động lực khuyến khích những người cung cấp tài nguyên tham gia vào các dự án AI mã nguồn mở.

-

Kết hợp AI mã nguồn mở với công nghệ mã hóa có thể hỗ trợ phát triển mô hình quy mô lớn hơn, thúc đẩy đổi mới sáng tạo nhiều hơn, từ đó tạo ra các hệ thống AI tiên tiến hơn.

Mở đầu

Theo một cuộc khảo sát năm 2024 của Trung tâm Nghiên cứu Pew (Pew Research Center) khảo sát, 64% người Mỹ cho rằng mạng xã hội ảnh hưởng tiêu cực nhiều hơn tích cực đến đất nước; 78% cho biết các công ty mạng xã hội có quá nhiều quyền lực và ảnh hưởng trong chính trị; 83% tin rằng các nền tảng này rất có thể cố tình kiểm duyệt các quan điểm chính trị mà họ không đồng tình. Sự bất mãn với mạng xã hội gần như đã trở thành một điểm chung hiếm hoi trong xã hội Mỹ.

Nhìn lại hành trình phát triển mạng xã hội trong 20 năm qua, tình trạng này dường như đã được định sẵn. Câu chuyện không phức tạp: một vài công ty công nghệ lớn đã nắm bắt sự chú ý của người dùng, và quan trọng hơn là kiểm soát dữ liệu người dùng. Dù ban đầu mọi người từng hy vọng về sự mở cửa dữ liệu, nhưng các công ty này nhanh chóng thay đổi chiến lược, tận dụng dữ liệu để xây dựng hiệu ứng mạng mạnh mẽ không thể phá vỡ, đồng thời đóng cửa việc truy cập từ bên ngoài. Kết quả là ngày nay: ít hơn 10 công ty công nghệ lớn chi phối ngành công nghiệp mạng xã hội, tạo nên một cấu trúc "độc quyền nhóm". Vì trạng thái hiện tại cực kỳ có lợi cho họ, các công ty này hầu như không có động lực gì để thay đổi. Mô hình này là khép kín và thiếu cạnh tranh.

Ngày nay, con đường phát triển công nghệ AI dường như đang lặp lại kịch bản này, nhưng lần này tác động còn sâu rộng hơn. Một vài công ty công nghệ lớn đang kiểm soát GPU và dữ liệu, xây dựng các mô hình AI nền tảng và khóa chặt việc truy cập chúng. Đối với những người mới tham gia không có hàng tỷ đô la, việc phát triển một mô hình cạnh tranh gần như là điều không thể. Chỉ riêng chi phí tính toán để huấn luyện một mô hình nền tảng đã lên tới hàng tỷ đô la, trong khi các công ty mạng xã hội hưởng lợi từ đợt sóng công nghệ trước đó đang tận dụng quyền kiểm soát dữ liệu người dùng để phát triển các mô hình mà đối thủ khó lòng theo kịp. Chúng ta đang đi lại vết xe đổ của mạng xã hội, hướng tới một thế giới AI khép kín và thiếu cạnh tranh. Nếu xu hướng này tiếp tục, một vài công ty công nghệ sẽ có quyền kiểm soát không giới hạn đối với việc tiếp cận thông tin và cơ hội.

AI mã nguồn mở và “vấn đề tài nguyên”

Nếu chúng ta không muốn thấy một thế giới AI khép kín, thì lựa chọn nào dành cho chúng ta? Câu trả lời rõ ràng là phát triển các mô hình nền tảng dưới dạng các dự án mã nguồn mở. Trong lịch sử, đã có vô số dự án mã nguồn mở thành công xây dựng nên các phần mềm nền tảng mà chúng ta sử dụng hàng ngày. Ví dụ, thành công của Linux chứng minh rằng ngay cả phần mềm cốt lõi như hệ điều hành cũng có thể được phát triển theo cách mã nguồn mở. Vậy tại sao LLMs (mô hình ngôn ngữ lớn) lại không thể?

Tuy nhiên, các mô hình AI nền tảng đối mặt với những hạn chế đặc biệt khiến chúng khác biệt so với phần mềm truyền thống, điều này làm giảm đáng kể khả thi khi vận hành như một dự án mã nguồn mở thông thường. Cụ thể, các mô hình AI nền tảng đòi hỏi lượng tài nguyên tính toán và dữ liệu khổng lồ, vượt xa khả năng cá nhân. Khác với các dự án mã nguồn mở truyền thống chỉ phụ thuộc vào việc mọi người cống hiến thời gian, AI mã nguồn mở còn yêu cầu mọi người cống hiến sức mạnh tính toán và tài nguyên dữ liệu — đây chính là “vấn đề tài nguyên”.

Lấy mô hình LLaMa của Meta làm ví dụ, ta có thể hiểu rõ hơn về vấn đề tài nguyên này. Khác với các đối thủ như OpenAI hay Google, Meta không giấu mô hình sau API trả phí mà công bố trọng số của LLaMa để bất kỳ ai cũng có thể sử dụng miễn phí (với một số hạn chế). Những trọng số này chứa đựng kiến thức mà mô hình học được trong quá trình huấn luyện tại Meta, và là điều kiện cần thiết để chạy mô hình. Với những trọng số này, người dùng có thể tinh chỉnh mô hình hoặc sử dụng đầu ra của mô hình làm đầu vào cho một mô hình mới.

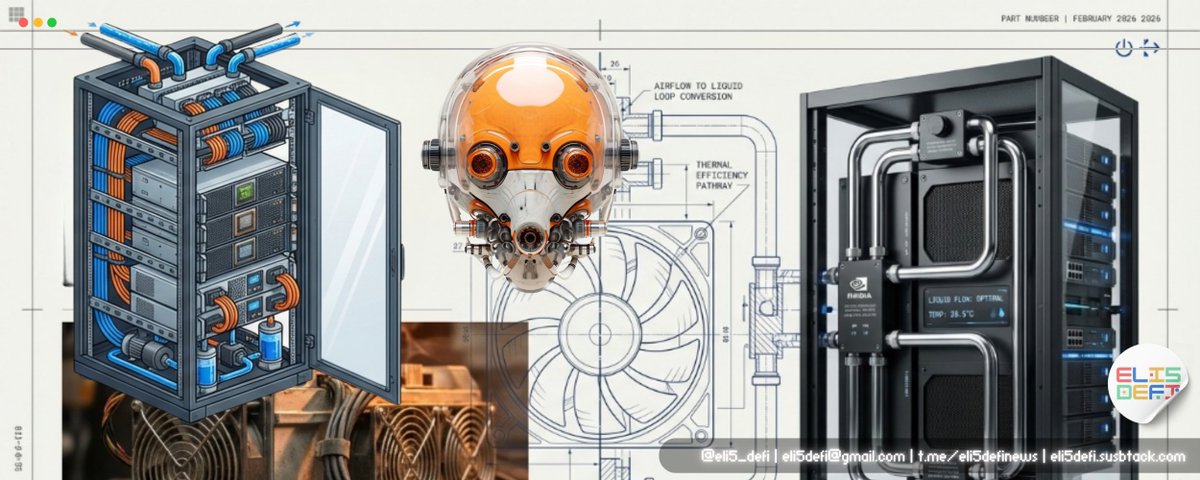

Dù việc Meta công bố trọng số LLaMa là điều đáng hoan nghênh, nhưng điều này chưa biến nó thành một dự án phần mềm mã nguồn mở thực thụ. Meta vẫn kiểm soát toàn bộ quá trình huấn luyện mô hình, dựa vào tài nguyên tính toán, dữ liệu và quyết định riêng của mình, đơn phương quyết định thời điểm công bố mô hình cho công chúng. Meta không mời gọi các nhà nghiên cứu độc lập hay nhà phát triển tham gia hợp tác cộng đồng, bởi vì tài nguyên cần để huấn luyện hoặc tái huấn luyện mô hình vượt xa khả năng của cá nhân bình thường. Những tài nguyên này bao gồm hàng chục ngàn GPU hiệu suất cao, các trung tâm dữ liệu để lưu trữ GPU, hệ thống làm mát phức tạp, cùng hàng nghìn tỷ token (đơn vị dữ liệu văn bản cần để huấn luyện). Như Báo cáo Chỉ số Trí tuệ Nhân tạo 2024 của Đại học Stanford chỉ ra: “Sự gia tăng mạnh mẽ về chi phí huấn luyện đang thực tế loại bỏ các trường đại học — vốn từng là trung tâm nghiên cứu AI — khỏi việc phát triển các mô hình nền tảng hàng đầu.” Ví dụ, Sam Altman từng nói chi phí huấn luyện GPT-4 lên tới 100 triệu đô la, chưa kể chi phí đầu tư cơ sở hạ tầng phần cứng. Ngoài ra, chi phí đầu tư của Meta trong quý II năm 2024 đã tăng thêm 2,1 tỷ đô so với cùng kỳ năm 2023, chủ yếu cho máy chủ, trung tâm dữ liệu và cơ sở hạ tầng mạng liên quan đến huấn luyện mô hình AI. Do đó, mặc dù các cộng sự viên cộng đồng LLaMa có thể có đủ năng lực kỹ thuật để cải tiến kiến trúc mô hình, họ lại thiếu tài nguyên để hiện thực hóa các cải tiến đó.

Tóm lại, khác với các dự án phần mềm mã nguồn mở truyền thống, các dự án AI mã nguồn mở không chỉ yêu cầu cộng sự viên cống hiến thời gian, mà còn phải gánh chi phí tính toán và dữ liệu cao ngất. Việc chỉ dựa vào thiện chí và tinh thần tình nguyện để thu hút đủ người cung cấp tài nguyên là không thực tế. Họ cần cơ chế khuyến khích bổ sung. Lấy mô hình mã nguồn mở quy mô lớn BLOOM làm ví dụ, mô hình 176 tỷ tham số này tập hợp nỗ lực của 1.000 nhà nghiên cứu tình nguyện từ hơn 70 quốc gia và 250 tổ chức. Mặc dù thành công của BLOOM rất đáng ngưỡng mộ (tôi hoàn toàn ủng hộ), nhưng nó mất một năm để phối hợp một lần huấn luyện và phụ thuộc vào khoản tài trợ 3 triệu euro từ một tổ chức nghiên cứu Pháp (chưa kể chi phí đầu tư cho siêu máy tính dùng để huấn luyện). Việc phải chờ đợi một vòng tài trợ mới để phối hợp và lặp lại quy trình BLOOM là quá rườm rà, không thể sánh tốc độ với các phòng thí nghiệm công nghệ lớn. Kể từ khi BLOOM ra mắt đã hơn hai năm, hiện chưa nghe tin nhóm này phát triển bất kỳ mô hình kế nhiệm nào.

Để biến AI mã nguồn mở thành hiện thực, chúng ta cần tìm ra cách khuyến khích những người cung cấp tài nguyên đóng góp sức mạnh tính toán và dữ liệu của họ, thay vì để các cộng sự viên tự gánh chi phí này.

Tại sao công nghệ mã hóa có thể giải quyết “vấn đề tài nguyên” trong AI mã nguồn mở nền tảng

Bước đột phá cốt lõi của công nghệ mã hóa nằm ở cơ chế "quyền sở hữu", giúp các dự án phần mềm mã nguồn mở tốn nhiều tài nguyên trở nên khả thi. Nó giải quyết vấn đề tài nguyên của AI mã nguồn mở bằng cách khuyến khích những người cung cấp tiềm năng tham gia mạng lưới, thay vì để cộng sự viên phải tự chịu chi phí tài nguyên từ đầu.

Bitcoin là một ví dụ điển hình. Là dự án mã hóa sớm nhất, Bitcoin là một dự án phần mềm hoàn toàn mã nguồn mở, mã nguồn của nó công khai từ ban đầu. Tuy nhiên, chính mã nguồn không phải là yếu tố then chốt của Bitcoin. Việc chỉ tải và chạy phần mềm nút Bitcoin, tạo một chuỗi khối cục bộ là vô nghĩa. Giá trị thực sự của phần mềm chỉ hiện hữu khi lượng tính toán đào khối đủ lớn để vượt xa khả năng của bất kỳ cá nhân đóng góp nào: duy trì một sổ cái phi tập trung, không ai kiểm soát. Tương tự như AI mã nguồn mở nền tảng, Bitcoin cũng là một dự án mã nguồn mở cần tài nguyên vượt quá khả năng cá nhân. Dù lý do nhu cầu tài nguyên tính toán khác nhau — Bitcoin cần tài nguyên để đảm bảo mạng lưới không thể bị sửa đổi, trong khi AI nền tảng cần tài nguyên để tối ưu và lặp lại mô hình — điểm chung là cả hai đều phụ thuộc vào tài nguyên vượt khả năng cá nhân.

Bitcoin và bất kỳ mạng lưới mã hóa nào khác có thể khuyến khích người tham gia cung cấp tài nguyên cho dự án phần mềm mã nguồn mở nhờ “bí mật” là phân phối quyền sở hữu mạng lưới thông qua Token. Như Jesse đã viết trong bài lập luận sáng lập cho Variant năm 2020: quyền sở hữu cung cấp động lực mạnh mẽ, khiến người cung cấp tài nguyên sẵn sàng đóng góp để đổi lấy lợi ích tiềm năng từ mạng lưới. Cơ chế này tương tự như các startup dùng “cổ phần lao động” (Sweat Equity) để giải quyết thiếu hụt vốn ban đầu — bằng cách trả lương cho nhân viên giai đoạn đầu (ví dụ như người sáng lập) chủ yếu dưới dạng cổ phần công ty, startup có thể thu hút lao động mà họ không đủ khả năng chi trả. Công nghệ mã hóa mở rộng khái niệm “cổ phần lao động” từ tập trung vào người đóng góp thời gian sang cả những người cung cấp tài nguyên. Vì vậy, Variant tập trung đầu tư vào các dự án sử dụng cơ chế sở hữu để xây dựng hiệu ứng mạng, như Uniswap, Morpho và World.

Nếu chúng ta muốn biến AI mã nguồn mở thành hiện thực, thì cơ chế sở hữu thông qua công nghệ mã hóa chính là giải pháp then chốt để giải quyết vấn đề tài nguyên. Cơ chế này cho phép các nhà nghiên cứu tự do đóng góp ý tưởng thiết kế mô hình của họ vào dự án mã nguồn mở, bởi vì tài nguyên tính toán và dữ liệu cần để hiện thực hóa những ý tưởng này sẽ do người cung cấp tài nguyên đảm nhận, và họ sẽ được đền bù bằng quyền sở hữu một phần dự án, thay vì buộc các nhà nghiên cứu phải tự gánh chi phí khởi tạo cao ngất. Trong AI mã nguồn mở, quyền sở hữu có thể có nhiều hình thức, nhưng hình thức hấp dẫn nhất là sở hữu chính mô hình, cũng là giải pháp mà Pluralis đề xuất.

Phương pháp mà Pluralis đề xuất được gọi là Các Mô hình Giao thức (Protocol Models). Trong mô hình này, những người cung cấp tài nguyên tính toán có thể đóng góp sức mạnh xử lý để huấn luyện một mô hình mã nguồn mở cụ thể, và từ đó nhận được quyền sở hữu một phần doanh thu suy luận (inference revenue) tương lai của mô hình đó. Vì quyền sở hữu gắn liền với mô hình cụ thể và giá trị của nó dựa trên doanh thu suy luận, người cung cấp tài nguyên tính toán sẽ có động lực chọn mô hình tối ưu để huấn luyện, và sẽ không làm giả dữ liệu huấn luyện (vì cung cấp dữ liệu vô ích sẽ trực tiếp làm giảm giá trị kỳ vọng từ doanh thu suy luận tương lai). Tuy nhiên, một câu hỏi quan trọng đặt ra: nếu quá trình huấn luyện cần gửi trọng số mô hình đến người cung cấp, làm sao Pluralis đảm bảo an ninh quyền sở hữu? Câu trả lời nằm ở việc sử dụng kỹ thuật “phân song song mô hình” (Model Parallelism) để phân mảnh mô hình và phân phát đến các máy xử lý khác nhau. Một đặc tính quan trọng của mạng nơ-ron là: ngay cả khi chỉ biết một phần rất nhỏ trọng số mô hình, người tính toán vẫn có thể tham gia huấn luyện, từ đó đảm bảo tập trọng số đầy đủ không thể bị trích xuất. Hơn nữa, do trên nền tảng Pluralis đồng thời huấn luyện nhiều mô hình khác nhau, người huấn luyện sẽ đối mặt với vô số tập trọng số khác nhau, khiến việc tái tạo mô hình hoàn chỉnh trở nên cực kỳ khó khăn.

Tư tưởng cốt lõi của Protocol Models là: các mô hình này có thể được huấn luyện, được sử dụng, nhưng không thể bị rút ra toàn bộ khỏi giao thức (trừ khi dùng lượng tính toán vượt quá chi phí huấn luyện mô hình từ đầu). Cơ chế này giải quyết vấn đề thường được các nhà phê bình AI mã nguồn mở nêu ra, đó là các đối thủ khép kín có thể ăn cắp thành quả lao động của các dự án mã nguồn mở.

Tại sao mã hóa + mã nguồn mở = AI tốt hơn

Ở đầu bài viết, tôi đã phân tích việc các công ty công nghệ lớn kiểm soát AI để chỉ ra những vấn đề đạo đức và chuẩn tắc của mô hình AI khép kín. Nhưng trong một thời đại mạng lưới tràn ngập cảm giác bất lực, tôi lo rằng lập luận này có thể khó lay chuyển đa số độc giả. Vì vậy, tôi muốn đưa ra hai lý do dựa trên hiệu quả thực tiễn, giải thích vì sao AI mã nguồn mở được hỗ trợ bởi công nghệ mã hóa thực sự có thể mang lại AI tốt hơn.

Thứ nhất, sự kết hợp giữa công nghệ mã hóa và AI mã nguồn mở có thể huy động nhiều tài nguyên hơn, từ đó thúc đẩy sự phát triển của thế hệ tiếp theo các mô hình nền tảng (Foundation Models). Các nghiên cứu cho thấy, dù là tăng cường năng lực tính toán hay tài nguyên dữ liệu, đều giúp nâng cao hiệu suất mô hình — đây cũng là lý do vì sao quy mô các mô hình nền tảng liên tục mở rộng. Bitcoin đã cho chúng ta thấy tiềm năng về năng lực tính toán khi kết hợp phần mềm mã nguồn mở với công nghệ mã hóa. Nó đã trở thành mạng lưới tính toán lớn nhất và mạnh nhất thế giới, quy mô vượt xa tài nguyên điện toán đám mây mà các công ty công nghệ lớn sở hữu. Điểm độc đáo của công nghệ mã hóa là nó có thể biến cạnh tranh phân tán thành cạnh tranh hợp tác. Bằng cách khuyến khích những người cung cấp tài nguyên đóng góp để giải quyết vấn đề chung, thay vì tự thân vận động và làm lại công việc trùng lặp, mạng lưới mã hóa đạt được hiệu quả sử dụng tài nguyên cao. AI mã nguồn mở được hỗ trợ bởi công nghệ mã hóa sẽ có thể tận dụng tài nguyên tính toán và dữ liệu toàn cầu để xây dựng các mô hình có quy mô vượt xa AI khép kín. Ví dụ, công ty Hyperbolic đã chứng minh tiềm năng của mô hình này. Họ tạo ra một thị trường mở, cho phép bất kỳ ai thuê GPU với chi phí thấp, từ đó tận dụng tối đa tài nguyên tính toán phân tán.

Thứ hai, sự kết hợp giữa công nghệ mã hóa và AI mã nguồn mở sẽ thúc đẩy đổi mới sáng tạo diễn ra nhanh hơn. Bởi một khi giải quyết được vấn đề tài nguyên, nghiên cứu học máy có thể quay trở lại bản chất mã nguồn mở, mang tính lặp lại cao và đổi mới mạnh mẽ. Trước khi xuất hiện các mô hình ngôn ngữ lớn (LLM) nền tảng, các nhà nghiên cứu trong lĩnh vực học máy thường công bố công khai mô hình và bản thiết kế có thể sao chép của họ. Các mô hình này thường dùng tập dữ liệu mã nguồn mở, nhu cầu tính toán cũng tương đối thấp, cho phép các nhà nghiên cứu liên tục tối ưu và đổi mới trên nền tảng đó. Chính quá trình lặp lại mở này đã thúc đẩy nhiều bước đột phá trong mô hình hóa tuần tự, như mạng nơ-ron hồi tiếp (RNN), mạng LSTM (Long Short-Term Memory), và cơ chế chú ý (Attention Mechanisms), cuối cùng dẫn đến sự ra đời của kiến trúc mô hình Transformer. Tuy nhiên, cách nghiên cứu mở này đã thay đổi kể từ khi GPT-3 ra đời. OpenAI đã chứng minh qua thành công của GPT-3 và ChatGPT rằng, chỉ cần đầu tư đủ tài nguyên tính toán và dữ liệu, ta có thể huấn luyện ra các mô hình ngôn ngữ lớn có khả năng hiểu ngôn ngữ. Xu hướng này khiến ngưỡng tài nguyên tăng vọt, đẩy giới học thuật dần bị loại khỏi cuộc chơi, đồng thời các công ty công nghệ lớn để duy trì lợi thế cạnh tranh cũng ngừng công bố kiến trúc mô hình của họ. Tình trạng này đã hạn chế khả năng thúc đẩy công nghệ AI lên phía trước.

AI mã nguồn mở được thực hiện thông qua công nghệ mã hóa có thể thay đổi hiện trạng này. Nó cho phép các nhà nghiên cứu tiếp tục lặp lại trên các mô hình tiên tiến, từ đó tìm ra “Transformer tiếp theo”. Sự kết hợp này không chỉ giải quyết vấn đề tài nguyên mà còn tái kích hoạt năng lượng đổi mới trong lĩnh vực học máy, mở ra con đường rộng lớn hơn cho tương lai phát triển của AI.

Chào mừng tham gia cộng đồng chính thức TechFlow

Nhóm Telegram:https://t.me/TechFlowDaily

Tài khoản Twitter chính thức:https://x.com/TechFlowPost

Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News