Galaxy Digital: Hiểu về điểm giao thoa giữa tiền mã hóa và trí tuệ nhân tạo

Tuyển chọn TechFlowTuyển chọn TechFlow

Galaxy Digital: Hiểu về điểm giao thoa giữa tiền mã hóa và trí tuệ nhân tạo

Sự xuất hiện của blockchain công cộng là một trong những bước tiến sâu sắc nhất trong lịch sử khoa học máy tính, và sự phát triển của trí tuệ nhân tạo sẽ và đang tạo ra ảnh hưởng sâu rộng đến thế giới của chúng ta.

Tác giả: Lucas Tcheyan

Biên dịch: Block unicorn

Giới thiệu

Sự xuất hiện của blockchain công khai là một trong những bước tiến sâu sắc nhất trong lịch sử khoa học máy tính. Trong khi đó, sự phát triển của trí tuệ nhân tạo (AI) đang và sẽ tiếp tục tác động sâu rộng đến thế giới của chúng ta. Nếu công nghệ blockchain cung cấp một khuôn mẫu mới cho việc thanh toán giao dịch, lưu trữ dữ liệu và thiết kế hệ thống, thì AI chính là cuộc cách mạng trong lĩnh vực tính toán, phân tích và phân phối nội dung. Những đổi mới từ cả hai lĩnh vực này đang mở ra các trường hợp sử dụng mới, có khả năng thúc đẩy việc áp dụng rộng rãi hơn ở cả hai ngành trong những năm tới. Báo cáo này khám phá sự tích hợp liên tục giữa tiền mã hóa và AI, tập trung vào các ứng dụng mới nhằm thu hẹp khoảng cách giữa hai lĩnh vực và tận dụng sức mạnh của cả hai. Cụ thể, báo cáo nghiên cứu các dự án phát triển giao thức tính toán phi tập trung, cơ sở hạ tầng học máy bằng chứng không kiến thức (zkML), cũng như các tác nhân AI.

Tiền mã hóa cung cấp cho AI một lớp thanh toán không cần sự cho phép, đáng tin cậy và có thể kết hợp được. Điều này mở ra nhiều trường hợp sử dụng, chẳng hạn như giúp dễ dàng tiếp cận phần cứng thông qua các hệ thống tính toán phi tập trung, xây dựng các tác nhân AI có thể thực hiện các nhiệm vụ phức tạp đòi hỏi trao đổi giá trị, và phát triển các giải pháp về danh tính và nguồn gốc để chống lại các cuộc tấn công Sybil hay deepfake. Ngược lại, AI mang lại cho tiền mã hóa nhiều lợi ích tương tự như những gì chúng ta đã thấy trong Web 2. Điều này bao gồm việc cải thiện trải nghiệm người dùng (UX) và nhà phát triển thông qua các mô hình ngôn ngữ lớn (LLM) như ChatGPT và Copilot chuyên biệt, đồng thời nâng cao đáng kể tiềm năng chức năng và tự động hóa của hợp đồng thông minh. Blockchain là môi trường phong phú và minh bạch mà AI cần. Tuy nhiên, khả năng tính toán hạn chế của blockchain là rào cản chính đối với việc tích hợp trực tiếp các mô hình AI.

Động lực đằng sau các thử nghiệm và việc áp dụng cuối cùng trong lĩnh vực giao thoa giữa tiền mã hóa và AI giống với động lực thúc đẩy các trường hợp sử dụng hứa hẹn nhất của tiền mã hóa —— đó là khả năng truy cập vào một lớp phối hợp không cần sự cho phép và không cần tin tưởng, từ đó thúc đẩy chuyển giao giá trị hiệu quả hơn. Trước tiềm năng to lớn này, các bên tham gia trong lĩnh vực này cần hiểu rõ các phương thức cơ bản mà hai công nghệ này giao thoa.

Các điểm chính:

-

Trong ngắn hạn (6 tháng đến 1 năm tới), sự tích hợp giữa tiền mã hóa và AI sẽ do các ứng dụng AI chi phối, nhằm nâng cao hiệu quả phát triển, khả năng kiểm toán và bảo mật của hợp đồng thông minh, cũng như tăng tính dễ tiếp cận cho người dùng. Các tích hợp này không riêng biệt với tiền mã hóa mà làm phong phú thêm trải nghiệm cho nhà phát triển và người dùng trên chuỗi.

-

Cũng như tình trạng khan hiếm GPU hiệu suất cao, các sản phẩm tính toán phi tập trung đang triển khai các sản phẩm GPU tùy chỉnh cho AI, tạo đà cho việc áp dụng.

-

Trải nghiệm người dùng và quy định vẫn là những trở ngại đối với việc thu hút khách hàng sử dụng tính toán phi tập trung. Tuy nhiên, những phát triển gần đây từ OpenAI cùng với sự giám sát ngày càng tăng từ chính phủ Mỹ làm nổi bật giá trị của các mạng AI phi tập trung, không cần sự cho phép và kháng kiểm duyệt.

-

Việc tích hợp AI trên chuỗi, đặc biệt là các hợp đồng thông minh có khả năng sử dụng mô hình AI, đòi hỏi phải cải thiện công nghệ zkML và các phương pháp xác minh tính toán ngoài chuỗi khác. Việc thiếu công cụ toàn diện, nhân tài phát triển và chi phí cao là những rào cản đối với việc áp dụng.

-

Các tác nhân AI rất phù hợp với tiền mã hóa, khi người dùng (hoặc chính tác nhân) có thể tạo ví để giao dịch với các dịch vụ, tác nhân hoặc cá nhân khác. Điều này hiện tại không thể thực hiện được qua các kênh tài chính truyền thống. Để đạt được sự phổ biến rộng rãi hơn, cần phải có thêm các tích hợp với các sản phẩm phi mã hóa.

Thuật ngữ

Trí tuệ nhân tạo (AI) là việc sử dụng máy móc và máy tính để bắt chước khả năng suy luận và giải quyết vấn đề của con người.

Mạng nơ-ron là một phương pháp huấn luyện mô hình AI. Chúng xử lý đầu vào qua các lớp thuật toán riêng biệt, điều chỉnh cho đến khi tạo ra đầu ra mong muốn. Mạng nơ-ron gồm các phương trình có trọng số, có thể điều chỉnh trọng số để thay đổi đầu ra. Chúng có thể yêu cầu lượng lớn dữ liệu và tính toán để huấn luyện nhằm đảm bảo độ chính xác của đầu ra. Đây là một trong những cách phổ biến nhất để phát triển mô hình AI (ChatGPT sử dụng quá trình mạng nơ-ron dựa trên Transformer).

Huấn luyện là quá trình phát triển mạng nơ-ron và các mô hình AI khác. Nó đòi hỏi lượng lớn dữ liệu để huấn luyện mô hình diễn giải đúng đầu vào và tạo ra đầu ra chính xác. Trong quá trình huấn luyện, trọng số của các phương trình trong mô hình được điều chỉnh liên tục cho đến khi tạo ra đầu ra thỏa mãn. Chi phí huấn luyện có thể rất cao. Ví dụ, ChatGPT sử dụng hàng chục ngàn GPU riêng để xử lý dữ liệu. Các nhóm có ít tài nguyên thường phụ thuộc vào các nhà cung cấp tính toán chuyên biệt như Amazon Web Services, Azure và Google Cloud.

Suy luận là việc sử dụng thực tế mô hình AI để nhận đầu ra hoặc kết quả (ví dụ: dùng ChatGPT tạo dàn ý cho bài luận về giao điểm giữa tiền mã hóa và AI). Suy luận được sử dụng trong suốt quá trình huấn luyện lẫn sản phẩm cuối cùng. Do chi phí tính toán, ngay cả sau khi huấn luyện xong, việc chạy chúng vẫn có thể tốn kém, nhưng mức độ yêu cầu tính toán thấp hơn so với huấn luyện.

Bằng chứng không kiến thức (ZKP) cho phép xác minh một tuyên bố mà không tiết lộ thông tin nền tảng. Điều này hữu ích trong tiền mã hóa vì hai lý do chính: 1) Riêng tư và 2) Mở rộng quy mô. Về riêng tư, nó cho phép người dùng giao dịch mà không tiết lộ thông tin nhạy cảm (ví dụ: số ETH trong ví). Về mở rộng, nó cho phép các tính toán ngoài chuỗi được chứng minh trên chuỗi nhanh hơn nhiều so với việc thực thi lại tính toán. Điều này cho phép blockchain và ứng dụng chạy tính toán rẻ tiền ngoài chuỗi, sau đó xác minh trên chuỗi. Để biết thêm về bằng chứng không kiến thức và vai trò của nó trong Máy ảo Ethereum, hãy đọc báo cáo zkEVMs: Tương lai của khả năng mở rộng Ethereum của Christine Kim.

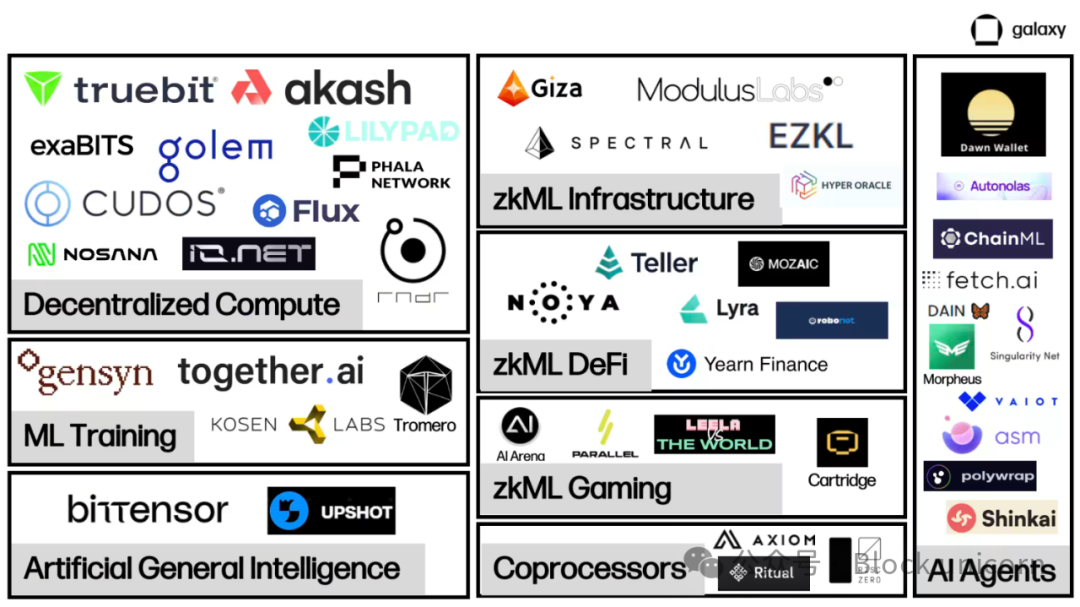

Bản đồ thị trường AI / Tiền mã hóa

Các dự án tích hợp AI và tiền mã hóa vẫn đang xây dựng cơ sở hạ tầng nền tảng cần thiết để hỗ trợ các tương tác AI quy mô lớn trên chuỗi.

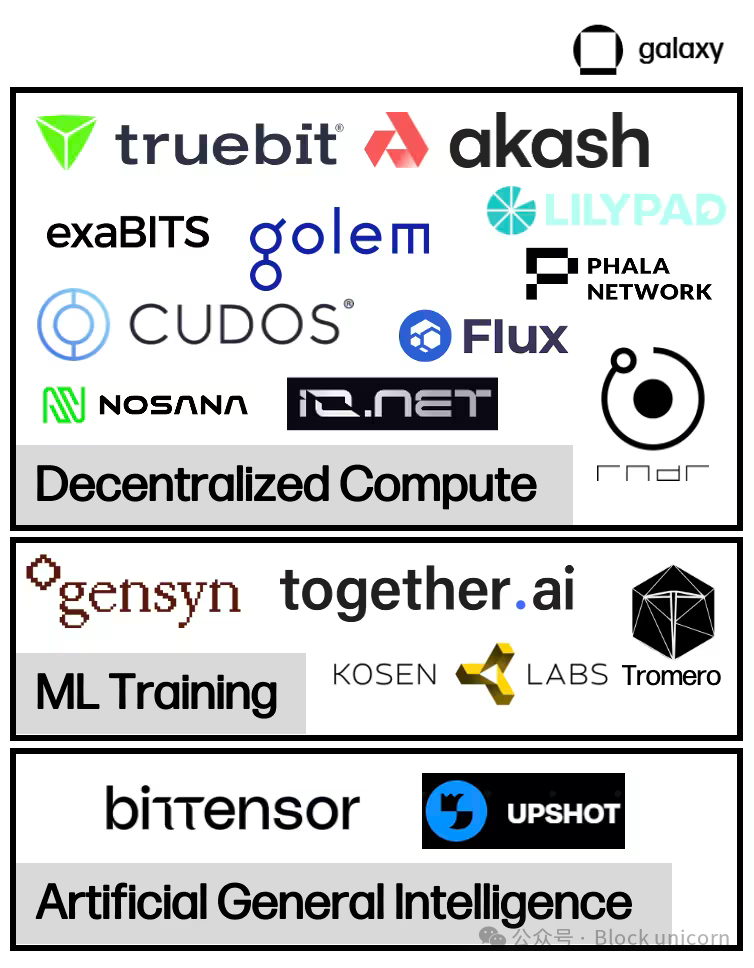

Các thị trường tính toán phi tập trung đang nổi lên nhằm cung cấp lượng lớn phần cứng vật lý cần thiết để huấn luyện và suy luận mô hình AI, chủ yếu dưới dạng đơn vị xử lý đồ họa (GPU). Các thị trường hai chiều này kết nối những người cho thuê và tìm thuê tài nguyên tính toán, thúc đẩy việc chuyển giao giá trị và xác minh tính toán. Trong lĩnh vực tính toán phi tập trung, một vài phân khúc cung cấp các chức năng bổ sung đang xuất hiện. Ngoài các thị trường hai chiều, báo cáo này cũng sẽ xem xét các nhà cung cấp chuyên về học máy cung cấp đầu ra huấn luyện và tinh chỉnh có thể xác minh được, cũng như các dự án tập trung vào kết nối tính toán và tạo mô hình cho AI, còn được gọi là các mạng khuyến khích thông minh.

zkML là một lĩnh vực mới nổi quan trọng đối với các dự án muốn cung cấp đầu ra mô hình có thể xác minh trên chuỗi một cách hiệu quả về mặt kinh tế và kịp thời. Các dự án này chủ yếu cho phép ứng dụng xử lý các yêu cầu tính toán nặng ngoài chuỗi, sau đó đăng tải đầu ra có thể xác minh lên chuỗi, chứng minh rằng khối lượng công việc ngoài chuỗi là hoàn chỉnh và chính xác. zkML hiện tại vẫn tốn kém và mất thời gian, nhưng ngày càng được sử dụng như một giải pháp. Điều này thể hiện rõ qua số lượng tích hợp ngày càng tăng giữa các nhà cung cấp zkML và các ứng dụng DeFi/trò chơi muốn tận dụng mô hình AI.

Nguồn cung tính toán dồi dào cùng khả năng xác minh tính toán trên chuỗi mở ra cánh cửa cho các tác nhân AI trên chuỗi. Tác nhân là các mô hình đã được huấn luyện, có khả năng thực hiện yêu cầu thay mặt người dùng. Tác nhân mở ra cơ hội cải thiện đáng kể trải nghiệm trên chuỗi, cho phép người dùng thực hiện các giao dịch phức tạp chỉ bằng cách trò chuyện với chatbot. Tuy nhiên, hiện tại các dự án tác nhân vẫn tập trung vào phát triển cơ sở hạ tầng và công cụ để triển khai nhanh chóng và dễ dàng.

Tính toán phi tập trung

Tổng quan

AI đòi hỏi lượng tính toán khổng lồ để huấn luyện mô hình và chạy suy luận. Trong thập kỷ qua, nhu cầu tính toán đã tăng theo cấp số nhân khi các mô hình ngày càng trở nên phức tạp. Ví dụ, OpenAI nhận thấy từ năm 2012 đến 2018, nhu cầu tính toán cho các mô hình của họ tăng gấp đôi từ mỗi hai năm xuống còn mỗi ba tháng rưỡi. Điều này dẫn đến nhu cầu bùng nổ đối với GPU, khiến một số thợ đào tiền mã hóa thậm chí tái sử dụng GPU của họ để cung cấp dịch vụ điện toán đám mây. Khi cạnh tranh về quyền truy cập vào tài nguyên tính toán gia tăng và chi phí leo thang, một số dự án đang tận dụng công nghệ mã hóa để cung cấp các giải pháp tính toán phi tập trung. Họ cung cấp tính toán theo yêu cầu với giá cạnh tranh, cho phép các đội ngũ huấn luyện và chạy mô hình một cách kinh tế. Trong một số trường hợp, sự đánh đổi có thể nằm ở hiệu suất và bảo mật.

Các GPU tiên tiến nhất (như những GPU do Nvidia sản xuất) đang có nhu cầu rất lớn. Tháng 9, Tether đã mua cổ phần của Northern Data, một thợ đào Bitcoin ở Đức, với khoản chi 420 triệu USD để mua 10.000 GPU H100 (một trong những GPU tiên tiến nhất dành cho huấn luyện AI). Thời gian chờ để có được phần cứng hàng đầu có thể kéo dài ít nhất sáu tháng, và trong nhiều trường hợp còn lâu hơn nữa. Tệ hơn nữa, các công ty thường bị yêu cầu ký hợp đồng dài hạn để truy cập vào lượng tính toán mà họ thậm chí có thể sẽ không dùng hết. Điều này có thể dẫn đến tình trạng có sẵn tính toán nhưng lại không có trên thị trường. Các hệ thống tính toán phi tập trung giúp giải quyết các vấn đề kém hiệu quả này bằng cách tạo ra một thị trường thứ cấp, nơi chủ sở hữu tài nguyên có thể cho thuê lại công suất dư thừa của họ ngay lập tức, từ đó giải phóng nguồn cung mới.

Ngoài định giá cạnh tranh và khả năng truy cập, điểm bán hàng chính của tính toán phi tập trung là khả năng kháng kiểm duyệt. Việc phát triển AI đỉnh cao ngày càng bị thống trị bởi các công ty công nghệ lớn có quyền truy cập vô song vào tài nguyên tính toán và dữ liệu. Chủ đề then chốt đầu tiên được nhấn mạnh trong Báo cáo Chỉ số AI hàng năm 2023 là ngành công nghiệp ngày càng vượt xa giới học thuật trong việc phát triển mô hình AI, tập trung quyền kiểm soát vào một vài lãnh đạo công nghệ. Điều này làm dấy lên lo ngại rằng họ có thể ảnh hưởng lớn đến việc thiết lập các chuẩn mực và giá trị làm nền tảng cho các mô hình AI, đặc biệt là sau khi các công ty công nghệ này thúc đẩy các quy định nhằm hạn chế sự phát triển AI mà họ không kiểm soát được.

Các lĩnh vực chuyên biệt của tính toán phi tập trung

Trong những năm gần đây, một vài mô hình tính toán phi tập trung đã xuất hiện, mỗi mô hình có trọng tâm và sự đánh đổi riêng.

Tính toán tổng quát

Các dự án như Akash, io.net, iExec, Cudos đều là các ứng dụng tính toán phi tập trung, cung cấp hoặc sắp cung cấp quyền truy cập vào tài nguyên tính toán chuyên dụng cho huấn luyện và suy luận AI, ngoài các giải pháp dữ liệu và tính toán tổng quát.

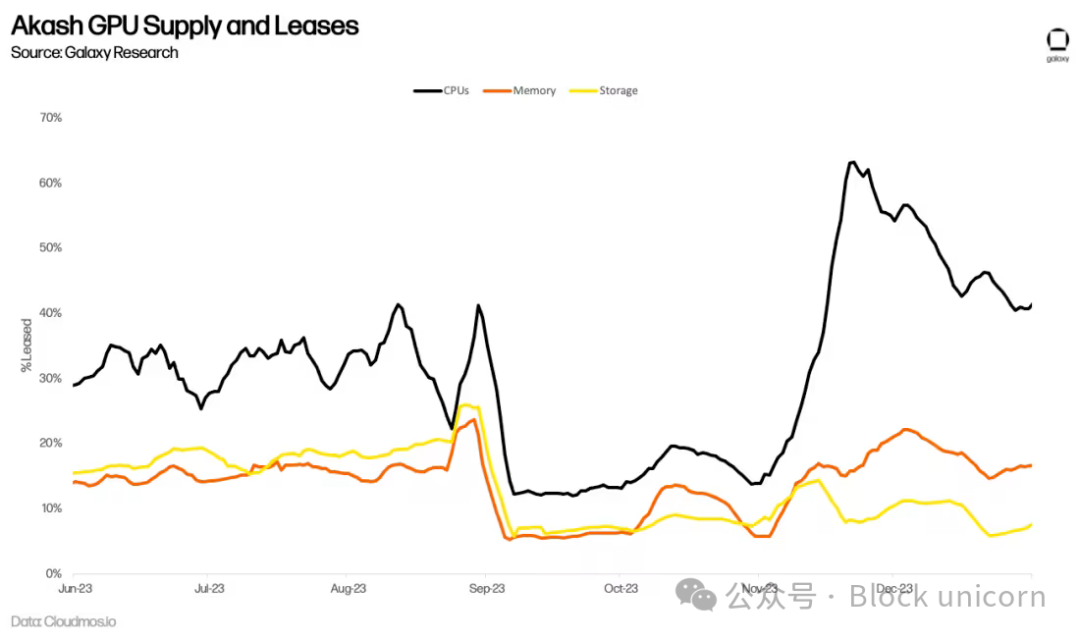

Akash hiện là nền tảng "siêu đám mây" duy nhất hoàn toàn mã nguồn mở. Nó là một mạng Proof-of-Stake sử dụng Cosmos SDK. AKT là token gốc của Akash, đóng vai trò như phương tiện thanh toán, bảo vệ an ninh mạng và khuyến khích sự tham gia. Akash ra mắt mainnet đầu tiên vào năm 2020, tập trung vào việc cung cấp thị trường điện toán đám mây không cần sự cho phép, ban đầu nổi bật với dịch vụ lưu trữ và cho thuê CPU. Tháng 6 năm 2023, Akash ra mắt một testnet mới tập trung vào GPU, và ra mắt mainnet GPU vào tháng 9, cho phép người dùng thuê GPU để huấn luyện và suy luận AI.

Hệ sinh thái Akash có hai bên tham gia chính - người thuê và nhà cung cấp. Người thuê là người dùng mạng Akash muốn mua tài nguyên tính toán. Nhà cung cấp là những người cung cấp tài nguyên tính toán. Để kết nối người thuê và nhà cung cấp, Akash dựa vào quy trình đấu giá ngược. Người thuê gửi yêu cầu tính toán của họ, trong đó có thể chỉ định một số điều kiện như vị trí máy chủ hoặc loại phần cứng để thực hiện tính toán, cùng với số tiền họ sẵn sàng trả. Sau đó, các nhà cung cấp đưa ra giá đặt của họ, và người đưa giá thấp nhất sẽ giành được nhiệm vụ.

Các bộ xác thực Akash duy trì tính toàn vẹn của mạng. Một bộ xác thực hiện tại bị giới hạn ở 100 và dự kiến sẽ tăng dần theo thời gian. Bất kỳ ai cũng có thể trở thành bộ xác thực bằng cách stake nhiều AKT hơn bộ xác thực có lượng AKT stake ít nhất hiện tại. Người nắm giữ AKT cũng có thể ủy thác AKT của họ cho các bộ xác thực. Phí giao dịch và phần thưởng khối của mạng được phân phối dưới dạng AKT. Ngoài ra, với mỗi hợp đồng thuê, mạng Akash kiếm được một khoản "phí thu" theo tỷ lệ do cộng đồng xác định và phân phối cho những người nắm giữ AKT.

Thị trường thứ cấp

Các thị trường tính toán phi tập trung nhằm lấp đầy khoảng trống kém hiệu quả của các thị trường tính toán hiện tại. Sự khan hiếm nguồn cung khiến các công ty tích trữ tài nguyên tính toán vượt quá nhu cầu thực tế, và cấu trúc hợp đồng của các nhà cung cấp đám mây khóa khách hàng vào các hợp đồng dài hạn, khiến nguồn cung bị hạn chế thêm dù có thể không cần truy cập liên tục. Các nền tảng tính toán phi tập trung giải phóng nguồn cung mới, cho phép bất kỳ ai trên thế giới có nhu cầu tính toán đều có thể trở thành nhà cung cấp.

Liệu nhu cầu bùng nổ đối với GPU phục vụ huấn luyện AI có chuyển hóa thành việc sử dụng mạng lưới lâu dài trên Akash hay không vẫn còn phải xem. Ví dụ, Akash từ lâu đã cung cấp thị trường cho CPU, cung cấp dịch vụ tương tự với mức giảm giá 70-80% so với các đối thủ tập trung. Tuy nhiên, giá thấp hơn chưa mang lại sự áp dụng đáng kể nào. Số hợp đồng thuê hoạt động trên mạng đã ổn định, đến quý II năm 2023, trung bình chỉ có 33% tài nguyên tính toán, 16% bộ nhớ và 13% lưu trữ được sử dụng. Mặc dù đây là những chỉ số ấn tượng đối với việc áp dụng trên chuỗi (để so sánh, nhà cung cấp lưu trữ hàng đầu Filecoin đã đạt tỷ lệ sử dụng lưu trữ 12,6% vào quý III năm 2023), điều này cho thấy nguồn cung cho các sản phẩm này vẫn vượt quá nhu cầu.

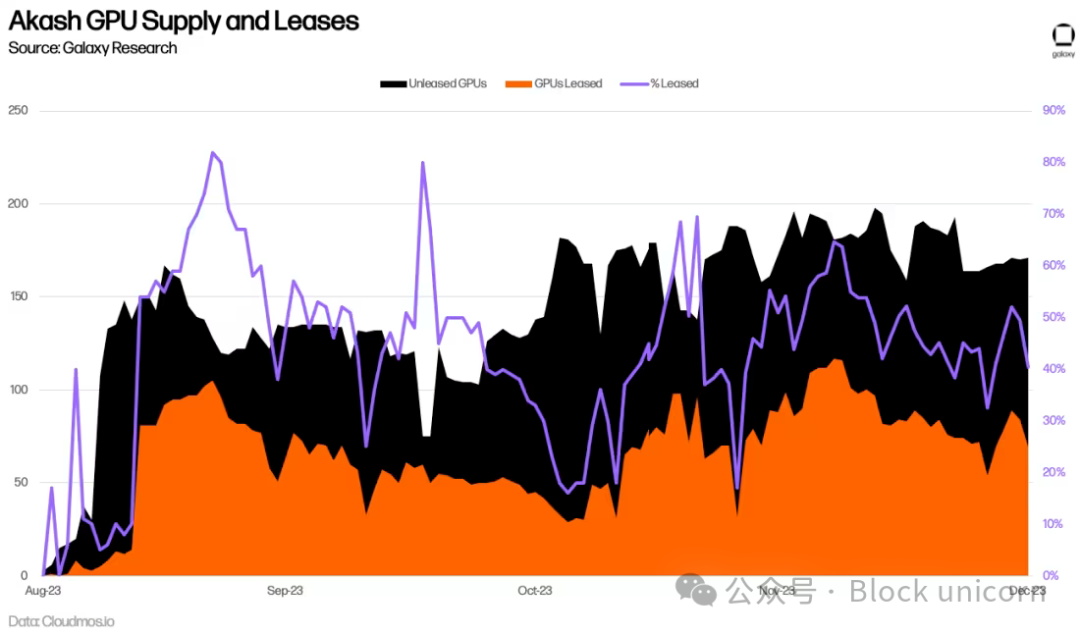

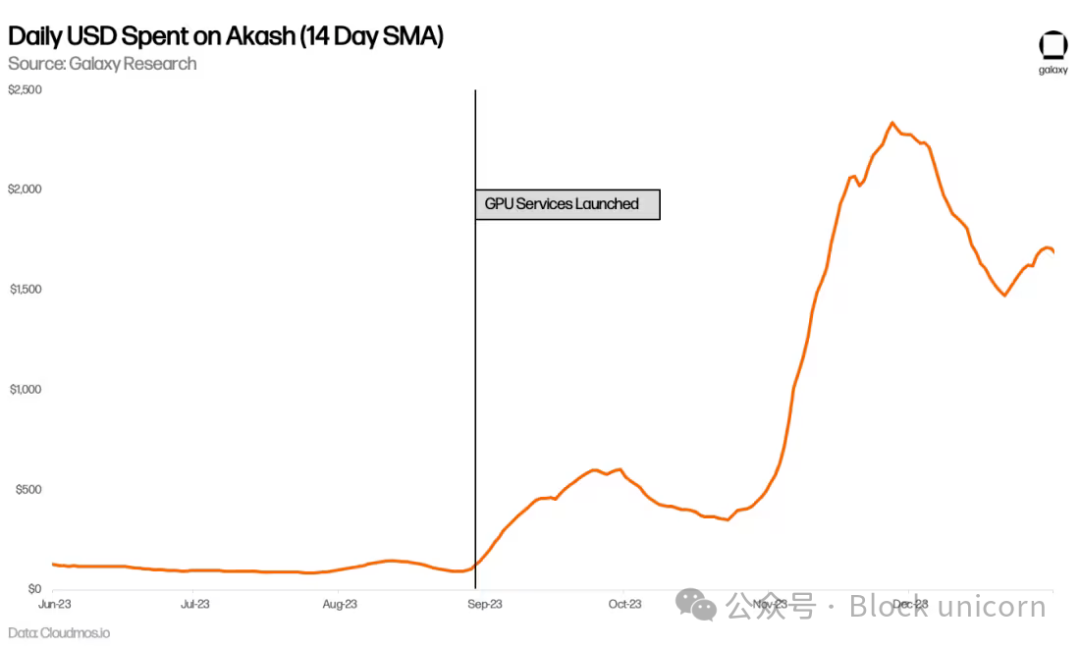

Đã hơn nửa năm kể từ khi Akash ra mắt mạng GPU, nên việc đánh giá chính xác tỷ lệ áp dụng lâu dài lúc này vẫn còn quá sớm. Cho đến nay, tỷ lệ sử dụng trung bình của GPU là 44%, cao hơn CPU, bộ nhớ và lưu trữ, đây là dấu hiệu của nhu cầu. Điều này chủ yếu được thúc đẩy bởi nhu cầu đối với các GPU chất lượng cao nhất (như A100), với hơn 90% đã được cho thuê.

Chi tiêu hàng ngày của Akash cũng tăng lên, gần như tăng gấp đôi so với trước khi có GPU. Phần này được góp phần bởi sự gia tăng sử dụng các dịch vụ khác, đặc biệt là CPU, nhưng chủ yếu là kết quả của việc sử dụng GPU mới.

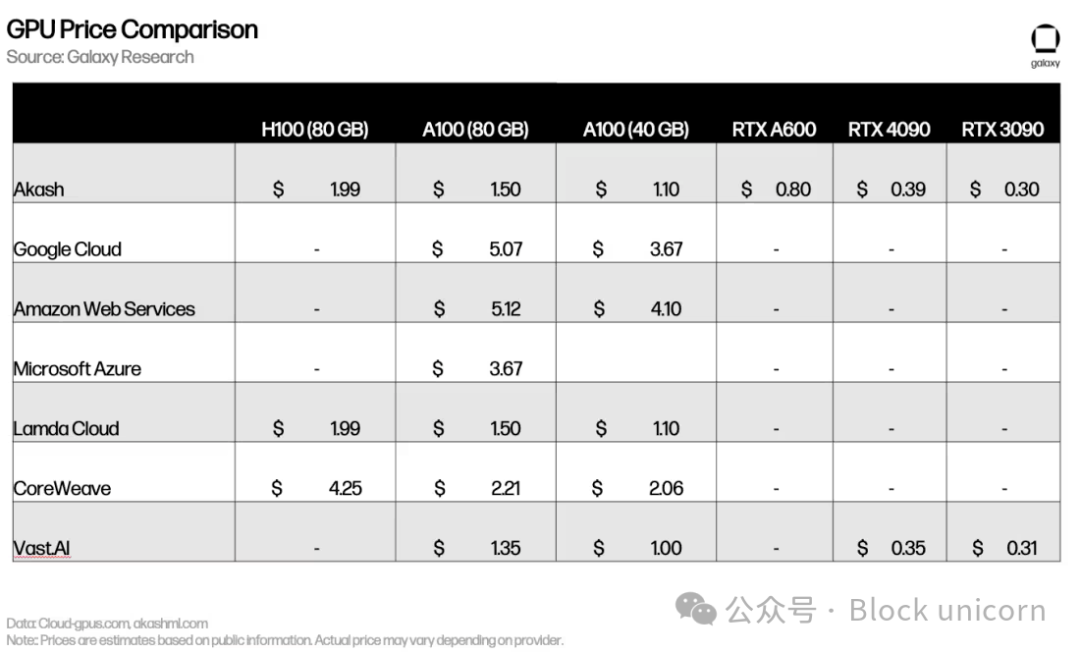

Định giá tương đương với các đối thủ tập trung như Lambda Cloud và Vast.ai (hoặc trong một số trường hợp còn đắt hơn). Nhu cầu cực lớn đối với các GPU hàng đầu (như H100 và A100) có nghĩa là phần lớn chủ sở hữu thiết bị này không mấy hứng thú với việc niêm yết trên thị trường có định giá cạnh tranh.

Mặc dù lợi nhuận ban đầu là tích cực, nhưng việc áp dụng vẫn gặp trở ngại (sẽ thảo luận thêm bên dưới). Các mạng tính toán phi tập trung cần thực hiện thêm nhiều biện pháp để tạo ra nhu cầu và nguồn cung, và các đội ngũ đang thử nghiệm cách tốt nhất để thu hút người dùng mới. Ví dụ, vào đầu năm 2024, Akash đã thông qua Đề xuất 240, tăng lượng phát hành AKT cho các nhà cung cấp GPU và khuyến khích thêm nguồn cung, đặc biệt tập trung vào GPU cao cấp. Đội ngũ cũng đang nỗ lực ra mắt các mô hình nguyên mẫu, nhằm minh họa chức năng thời gian thực của mạng cho người dùng tiềm năng. Akash đang huấn luyện mô hình cơ sở riêng của họ và đã ra mắt chatbot và sản phẩm tạo hình ảnh, có thể sử dụng GPU Akash để tạo đầu ra. Tương tự, io.net đã phát triển một mô hình khuếch tán ổn định và đang ra mắt các tính năng mạng mới để mô phỏng tốt hơn hiệu suất và quy mô của mạng.

Huấn luyện học máy phi tập trung

Ngoài các nền tảng tính toán tổng quát có thể đáp ứng nhu cầu AI, một nhóm các nhà cung cấp GPU AI chuyên biệt tập trung vào việc huấn luyện mô hình học máy cũng đang nổi lên. Ví dụ, Gensyn đang "tổ chức nguồn điện và phần cứng để xây dựng trí tuệ tập thể", với quan điểm rằng "nếu ai đó muốn huấn luyện một thứ gì đó, và có người sẵn sàng huấn luyện nó, thì việc huấn luyện đó nên được phép xảy ra."

Giao thức này có bốn bên tham gia chính: người nộp đơn, người giải quyết, người xác minh và người tố giác. Người nộp đơn gửi nhiệm vụ có yêu cầu huấn luyện lên mạng. Các nhiệm vụ này bao gồm mục tiêu huấn luyện, mô hình cần huấn luyện và dữ liệu huấn luyện. Là một phần của quá trình nộp đơn, người nộp đơn cần trả trước phí cho lượng tính toán ước tính mà người giải quyết cần.

Sau khi nộp, nhiệm vụ sẽ được giao cho người giải quyết, người sẽ thực hiện việc huấn luyện mô hình. Sau đó, người giải quyết nộp nhiệm vụ đã hoàn thành cho người xác minh, người chịu trách nhiệm kiểm tra việc huấn luyện để đảm bảo nó được thực hiện đúng cách. Người tố giác có trách nhiệm đảm bảo người xác minh hành xử trung thực. Để khuyến khích người tố giác tham gia mạng, Gensyn dự định định kỳ cung cấp các bằng chứng sai cố ý, thưởng cho người tố giác khi họ phát hiện ra.

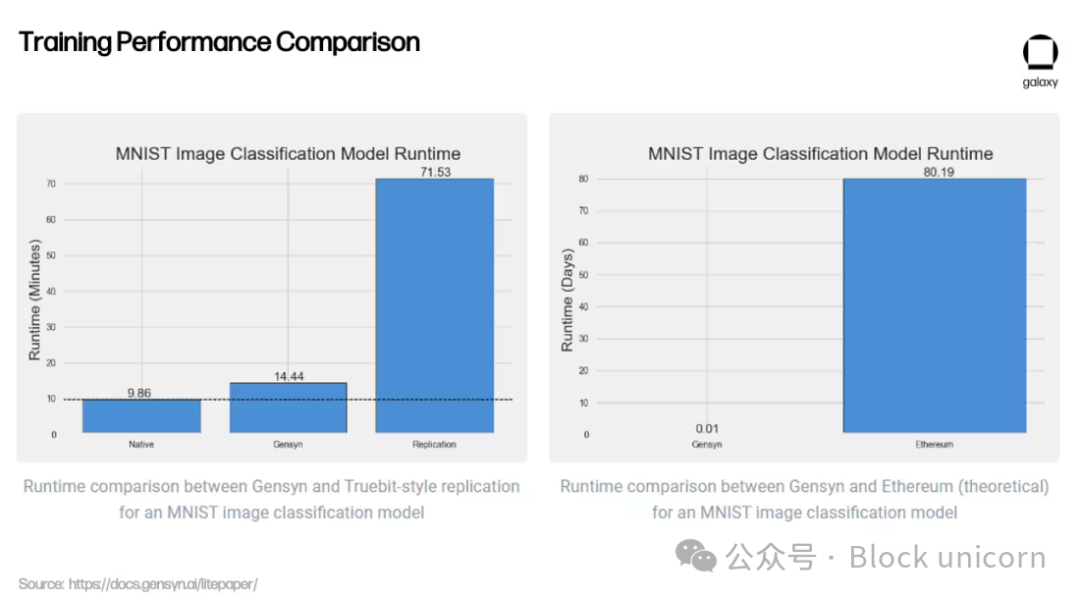

Ngoài việc cung cấp tính toán cho các khối lượng công việc liên quan đến AI, điểm bán hàng chính của Gensyn là hệ thống xác minh của họ, hiện vẫn đang trong quá trình phát triển. Để đảm bảo tính toán bên ngoài từ các nhà cung cấp GPU được thực hiện đúng (tức là đảm bảo mô hình của người dùng được huấn luyện theo đúng cách họ muốn), việc xác minh là cần thiết. Gensyn giải quyết vấn đề này bằng một phương pháp độc đáo, tận dụng một phương pháp xác minh mới lạ được gọi là "bằng chứng học xác suất, giao thức dựa trên đồ thị chính xác và trò chơi khuyến khích kiểu Truebit". Đây là một mô hình giải quyết lạc quan, cho phép người xác minh xác nhận người giải quyết đã chạy mô hình đúng mà không cần tự mình chạy lại toàn bộ mô hình – một quá trình tốn kém và kém hiệu quả.

Ngoài phương pháp xác minh sáng tạo, Gensyn còn tuyên bố có hiệu quả về chi phí so với các giải pháp tập trung và các đối thủ tiền mã hóa – cung cấp giá huấn luyện ML rẻ hơn tới 80% so với AWS, đồng thời vượt trội hơn các dự án tương tự như Truebit trong các bài kiểm tra.

Liệu những kết quả sơ bộ này có thể được nhân rộng quy mô trên mạng phi tập trung hay không vẫn còn phải xem. Gensyn hy vọng tận dụng năng lực tính toán dư thừa từ các trung tâm dữ liệu nhỏ, người dùng cá nhân và trong tương lai là các thiết bị di động nhỏ như điện thoại. Tuy nhiên, như chính đội ngũ Gensyn thừa nhận, việc phụ thuộc vào các nhà cung cấp tính toán dị biệt mang lại một số thách thức mới.

Đối với các nhà cung cấp tập trung như Google Cloud và Coreweave, chi phí tính toán đắt đỏ, trong khi chi phí truyền thông giữa các đơn vị tính toán (băng thông và độ trễ) lại rẻ. Các hệ thống này được thiết kế để truyền thông giữa phần cứng nhanh nhất có thể. Gensyn đảo ngược khung này bằng cách giảm chi phí tính toán thông qua việc cho phép bất kỳ ai trên thế giới cung cấp GPU, nhưng đồng thời làm tăng chi phí truyền thông, vì mạng hiện phải phối hợp các công việc tính toán trên phần cứng dị biệt cách xa nhau. Gensyn chưa ra mắt, nhưng nó là một minh chứng cho khái niệm về những gì có thể đạt được khi xây dựng giao thức huấn luyện học máy phi tập trung.

Trí tuệ chung phi tập trung

Các nền tảng tính toán phi tập trung cũng mở ra khả năng thiết kế phương pháp tạo ra AI. Bittensor là một giao thức tính toán phi tập trung được xây dựng trên Substrate, cố gắng trả lời câu hỏi: "Chúng ta làm thế nào để biến AI thành một phương pháp hợp tác?". Bittensor nhằm mục đích phi tập trung hóa và thương mại hóa việc tạo ra AI. Giao thức này ra mắt vào năm 2021, với hy vọng tận dụng sức mạnh của các mô hình học máy hợp tác để liên tục lặp lại và tạo ra AI tốt hơn.

Bittensor lấy cảm hứng từ Bitcoin, với nguồn cung token gốc TAO là 21 triệu, chu kỳ giảm một nửa là bốn năm (lần giảm đầu tiên sẽ diễn ra vào năm 2025). Thay vì sử dụng Proof-of-Work để tạo ra số ngẫu nhiên chính xác và nhận phần thưởng khối, Bittensor dựa vào "Proof-of-Intelligence", yêu cầu các thợ đào chạy mô hình để tạo ra đầu ra phản hồi các yêu cầu suy luận.

Khuyến khích trí tuệ

Ban đầu, Bittensor dựa vào mô hình Hỗn hợp các chuyên gia (MoE) để tạo ra đầu ra. Khi gửi yêu cầu suy luận, mô hình MoE sẽ không phụ thuộc vào một mô hình tổng quát duy nhất, mà chuyển tiếp yêu cầu suy luận đến mô hình chính xác nhất cho loại đầu vào nhất định. Hãy tưởng tượng việc xây một ngôi nhà, bạn thuê nhiều chuyên gia khác nhau để chịu trách nhiệm cho các khía cạnh khác nhau của quá trình xây dựng (ví dụ: kiến trúc sư, kỹ sư, thợ sơn, thợ xây...). MoE áp dụng điều này vào các mô hình học máy, cố gắng tận dụng đầu ra từ các mô hình khác nhau dựa trên đầu vào. Như Ala Shaabana, người sáng lập Bittensor, giải thích, điều này giống như "trò chuyện với cả một căn phòng đầy người thông minh để nhận được câu trả lời tốt nhất, thay vì chỉ nói chuyện với một người". Phương pháp này đã tạm ngừng do gặp thách thức trong việc đảm bảo định tuyến chính xác, đồng bộ hóa tin nhắn đến đúng mô hình và khuyến khích, cho đến khi dự án được phát triển thêm.

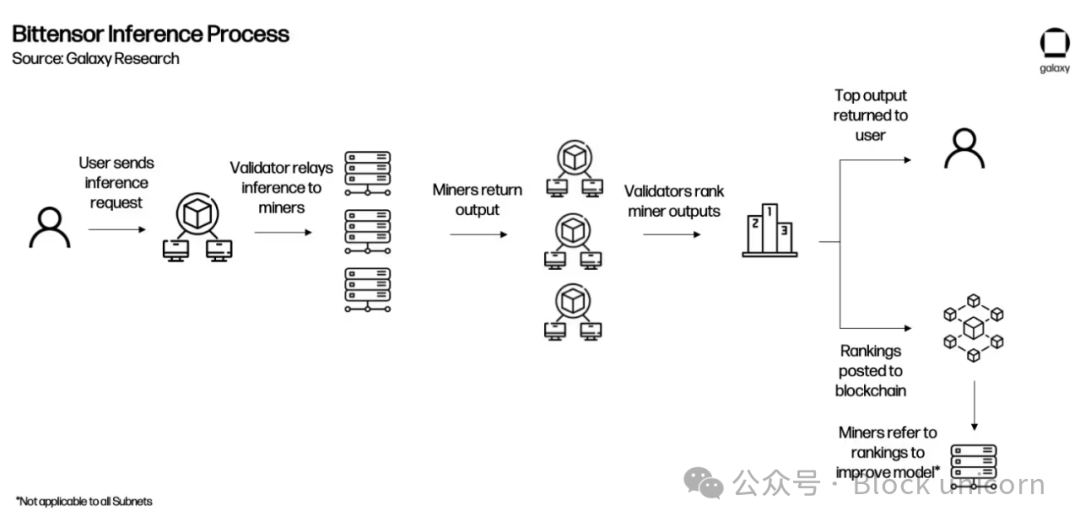

Mạng Bittensor có hai bên tham gia chính: người xác minh và thợ đào. Nhiệm vụ của người xác minh là gửi yêu cầu suy luận đến các thợ đào, xem xét đầu ra của họ và xếp hạng chúng dựa trên chất lượng phản hồi. Để đảm bảo xếp hạng của họ đáng tin cậy, người xác minh sẽ nhận được điểm "vtrust" dựa trên mức độ đồng thuận xếp hạng của họ với các người xác minh khác. Điểm vtrust của người xác minh càng cao, họ càng nhận được nhiều lượng phát hành TAO. Điều này nhằm khuyến khích người xác minh đạt được sự đồng thuận về xếp hạng mô hình theo thời gian, vì càng có nhiều người xác minh đồng thuận về xếp hạng, điểm vtrust cá nhân của họ càng cao.

Thợ đào, còn được gọi là máy chủ, là những người tham gia mạng chạy các mô hình học máy thực tế. Các thợ đào cạnh tranh với nhau để cung cấp đầu ra chính xác nhất cho một truy vấn nhất định từ người xác minh, đầu ra càng chính xác thì càng kiếm được nhiều lượng phát hành TAO. Các thợ đào có thể tạo ra các đầu ra này theo ý muốn. Ví dụ, trong tương lai, hoàn toàn có khả năng các thợ đào Bittensor đã từng huấn luyện mô hình trên Gensyn và sử dụng chúng để kiếm lượng phát hành TAO.

Ngày nay, phần lớn các tương tác diễn ra trực tiếp giữa người xác minh và thợ đào. Người xác minh gửi đầu vào đến các thợ đào và yêu cầu đầu ra (tức là mô hình huấn luyện). Sau khi người xác minh truy vấn các thợ đào trên mạng và nhận được phản hồi, họ sẽ xếp hạng các thợ đào và gửi xếp hạng lên mạng.

Tương tác này giữa người xác minh (dựa trên PoS) và thợ đào (dựa trên Proof-of-Model, một dạng PoW) được gọi là Yuma Consensus. Nó nhằm mục đích khuyến khích các thợ đào tạo ra đầu ra tốt nhất để kiếm lượng phát hành TAO, và khuyến khích người xác minh xếp hạng đầu ra của thợ đào một cách chính xác để có điểm vtrust cao hơn và tăng phần thưởng TAO, từ đó hình thành cơ chế đồng thuận của mạng.

Các subnet và ứng dụng

Các tương tác trên Bittensor chủ yếu bao gồm người xác minh gửi yêu cầu đến các thợ đào và đánh giá đầu ra của họ. Tuy nhiên, khi chất lượng của các thợ đào đóng góp được cải thiện và trí tuệ tổng thể của mạng tăng lên, Bittensor sẽ tạo ra một lớp ứng dụng trên nền tảng hiện tại, cho phép các nhà phát triển xây dựng các ứng dụng truy vấn mạng Bittensor.

Vào tháng 10 năm 2023, Bittensor đã giới thiệu các subnet thông qua bản nâng cấp Revolution, một bước tiến quan trọng hướng tới mục tiêu này. Subnet là các mạng riêng biệt trên Bittensor nhằm khuyến khích các hành vi cụ thể. Revolution mở mạng cho bất kỳ ai muốn tạo subnet. Trong vài tháng kể từ khi ra mắt, hơn 32 subnet đã được khởi động, bao gồm các subnet dành cho nhắc nhở văn bản, thu thập dữ liệu, tạo hình ảnh và lưu trữ. Khi các subnet trưởng thành và sẵn sàng cho sản phẩm, người tạo subnet cũng sẽ tạo các tích hợp ứng dụng, cho phép các đội ngũ xây dựng ứng dụng truy vấn subnet cụ thể. Một số ứng dụng (như chatbot, tạo hình ảnh, bot trả lời Twitter, thị trường dự đoán) hiện tại thực sự tồn tại, nhưng ngoài sự tài trợ từ Quỹ Bittensor, chưa có động lực chính thức nào để người xác minh chấp nhận và chuyển tiếp các truy vấn này.

Để minh họa rõ ràng hơn, dưới đây là một ví dụ về cách Bittensor có thể hoạt động sau khi các ứng dụng được tích hợp vào mạng.

Subnet kiếm được TAO dựa trên hiệu suất được đánh giá bởi mạng gốc. Mạng gốc nằm trên tất cả các subnet, về cơ bản đóng vai trò như một subnet đặc biệt và được quản lý bởi 64 người xác minh subnet lớn nhất theo tỷ lệ stake. Người xác minh mạng gốc xếp hạng các subnet dựa trên hiệu suất của chúng và định kỳ phân bổ lượng phát hành TAO cho các subnet. Theo cách này, các subnet riêng lẻ đóng vai trò như các thợ đào của mạng gốc.

Tầm nhìn của Bittensor

Bittensor vẫn đang trải qua những đau đớn khi trưởng thành khi mở rộng chức năng giao thức để khuyến khích việc tạo ra trí tuệ xuyên suốt nhiều subnet. Các thợ đào liên tục nghĩ ra những phương pháp mới để tấn công mạng nhằm kiếm thêm phần thưởng TAO, ví dụ như sửa đổi nhẹ đầu ra của suy luận được đánh giá cao bằng cách chạy mô hình của họ, sau đó gửi nhiều biến thể. Các đề xuất quản trị ảnh hưởng đến toàn bộ mạng chỉ có thể được gửi và thực hiện bởi Triumvirate, gồm những bên liên quan từ Quỹ Opentensor (lưu ý rằng đề xuất cần được Thượng viện Bittensor, gồm các bộ xác thực Bittensor, phê duyệt trước khi thực hiện). Kinh tế học token của dự án đang được sửa đổi để tăng cường động lực sử dụng TAO xuyên suốt các subnet. Dự án này cũng nhanh chóng nổi tiếng nhờ phương pháp độc đáo của mình, CEO của HuggingFace, một trong những trang web AI phổ biến nhất, cho biết Bittensor nên bổ sung tài nguyên của họ vào trang web này.

Trong một bài viết gần đây của các nhà phát triển cốt lõi có tên "Bittensor Paradigm", đội ngũ đã nêu bật tầm nhìn của Bittensor là cuối cùng phát triển thành "vô tri về nội dung đo lường". Về lý thuyết, điều này có thể cho phép Bittensor phát triển các subnet để khuyến khích bất kỳ loại hành vi nào được hỗ trợ bởi TAO. Tuy nhiên, vẫn tồn tại những giới hạn thực tế đáng kể —— đáng chú ý nhất là việc chứng minh các mạng này có thể mở rộng để xử lý các quy trình đa dạng như vậy, và các động lực tiềm năng thúc đẩy tiến bộ vượt trội hơn các sản phẩm tập trung.

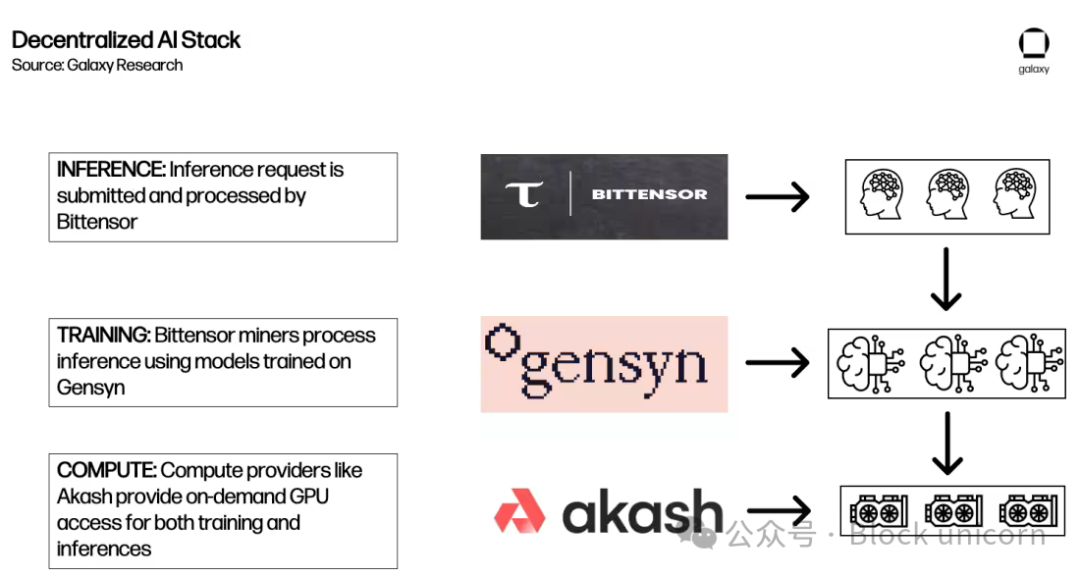

Xây dựng ngăn xếp tính toán phi tập trung cho các mô hình AI

Phần trên đã cung cấp cái nhìn sâu sắc về các loại giao thức tính toán AI phi tập trung khác nhau đang được phát triển. Trong giai đoạn phát triển và áp dụng ban đầu, chúng cung cấp nền tảng cho hệ sinh thái, cuối cùng có thể thúc đẩy việc tạo ra các "khối xây dựng AI", giống như khái niệm "Lego tiền tệ" trong DeFi. Khả năng kết hợp của blockchain không cần sự cho phép mở ra khả năng mỗi giao thức xây dựng trên giao thức khác để cung cấp một hệ sinh thái AI phi tập trung toàn diện hơn.

Ví dụ, dưới đây là một cách mà Akash, Gensyn và Bittensor có thể tương tác để phản hồi một yêu cầu suy luận.

Chào mừng tham gia cộng đồng chính thức TechFlow Nhóm Telegram:https://t.me/TechFlowDaily Tài khoản Twitter chính thức:https://x.com/TechFlowPost Tài khoản Twitter tiếng Anh:https://x.com/BlockFlow_News