Rapport conjoint annuel BlockSec × Bitget | IA × Trading × Sécurité : l’évolution des risques à l’ère du trading intelligent

TechFlow SélectionTechFlow Sélection

Rapport conjoint annuel BlockSec × Bitget | IA × Trading × Sécurité : l’évolution des risques à l’ère du trading intelligent

Cet article examinera, à partir de trois dimensions fondamentales — la formation de nouveaux scénarios, l’amplification de nouveaux défis et l’émergence de nouvelles opportunités — les évolutions clés en cours à l’intersection de l’IA, du trading et de la sécurité, ainsi que les orientations stratégiques adoptées par le secteur.

Préface

Au cours de la dernière année, le rôle de l’IA dans l’univers Web3 a connu une transformation fondamentale : elle n’est plus seulement un outil d’assistance permettant aux humains de comprendre plus rapidement les informations ou de générer des conclusions analytiques ; elle devient désormais un moteur central pour améliorer l’efficacité des transactions et optimiser la qualité des décisions, s’intégrant profondément dans l’ensemble du cycle réel — de l’initiation à l’exécution concrète, puis au transfert des fonds. À mesure que les grands modèles, les agents IA et les systèmes d’exécution automatisés mûrissent, le modèle transactionnel évolue progressivement depuis la forme traditionnelle « l’humain lance, la machine assiste » vers une nouvelle configuration : « la machine planifie, la machine exécute, l’humain supervise ».

Parallèlement, les trois caractéristiques fondamentales propres au Web3 — données publiques, compositionnalité des protocoles et règlement irréversible — confèrent à cette transformation automatisée une double nature marquée : elle offre un potentiel sans précédent d’amélioration de l’efficacité, tout en accompagnant une courbe de risque nettement plus abrupte.

Cette transformation façonne simultanément trois nouveaux scénarios concrets :

Premièrement, une mutation radicale des scénarios transactionnels : l’IA commence à assumer de façon autonome des fonctions décisionnelles clés telles que l’identification des signaux, la génération de stratégies et le choix des parcours d’exécution ; elle peut même réaliser directement des paiements et des appels intermachines via des mécanismes innovants comme x402, accélérant ainsi la formation d’un « système transactionnel exécutable par machine » ;

Deuxièmement, une montée en puissance des risques et des formes d’attaque : dès lors que l’ensemble du processus transactionnel et d’exécution est automatisé, la compréhension des vulnérabilités, la génération de chemins d’attaque et le blanchiment de fonds illégaux deviennent eux aussi automatisés et échelonnés à grande échelle. La vitesse de propagation des risques dépasse désormais de façon stable la limite d’intervention humaine — autrement dit, les risques se diffusent plus vite que les humains ne peuvent réagir ou intervenir.

Troisièmement, de nouvelles opportunités dans les domaines de la sécurité, de la gestion des risques et de la conformité : seule une transformation ingénierie, automatisée et standardisée (via des interfaces) des capacités en matière de sécurité, de gestion des risques et de conformité permettra au système transactionnel intelligent de rester contrôlable tout en améliorant son efficacité, garantissant ainsi un développement durable.

C’est précisément dans ce contexte sectoriel que BlockSec et Bitget ont conjointement rédigé ce rapport. Nous ne cherchons pas à débattre de la question fondamentale « faut-il ou non utiliser l’IA », mais plutôt à nous concentrer sur une problématique plus concrète et essentielle : lorsque les transactions, leur exécution et les paiements deviennent entièrement exécutables par machine, comment la structure des risques du Web3 évolue-t-elle en profondeur, et comment le secteur doit-il reconstruire ses capacités fondamentales en matière de sécurité, de gestion des risques et de conformité afin de répondre à cette transformation ? Cet article aborde ces changements clés et les orientations sectorielles correspondantes à travers trois dimensions centrales : l’émergence de nouveaux scénarios, l’amplification de nouveaux défis, et l’apparition de nouvelles opportunités, dans la zone de convergence entre IA, trading et sécurité.

Chapitre 1 : L’évolution des capacités de l’IA et sa logique d’intégration au Web3

L’IA passe progressivement d’un simple outil d’aide à la prise de décision à un système d’agents doté de capacités de planification, d’appel d’outils et d’exécution fermée. Le Web3 possède naturellement trois caractéristiques fondamentales — données publiques, protocoles composites et règlement irréversible — qui rendent les applications automatisées plus rentables, mais rendent également les erreurs opérationnelles ou les attaques malveillantes plus coûteuses. Cette caractéristique essentielle détermine que, lorsqu’on discute des questions de cybersécurité, d’attaques et de conformité dans le domaine Web3, il ne s’agit pas simplement d’appliquer des outils IA à des processus existants, mais bien d’une migration systémique complète — les domaines des transactions, de la gestion des risques et de la sécurité évoluent tous ensemble vers un mode « exécutable par machine ».

1. L’évolution des capacités de l’IA dans le trading financier et la gestion des risques : du « simple outil d’assistance » au « système décisionnel autonome »

Si l’on considère l’évolution du rôle de l’IA dans le trading financier et la gestion des risques comme une chaîne claire, le point critique le plus important réside dans la capacité ou non du système à effectuer une exécution fermée.

Les premiers systèmes basés sur des règles ressemblaient davantage à « des outils automatisés équipés d’un frein » : leur cœur consistait à traduire l’expertise humaine en seuils de jugement explicites, en listes blanches/noires et en stratégies fixes de gestion des risques. Ce modèle présentait l’avantage d’une logique explicite et d’un faible coût de gouvernance, mais souffrait également d’un inconvénient majeur : sa lenteur extrême face aux nouveaux modèles d’affaires et aux comportements d’attaque adversariaux. Avec l’augmentation de la complexité opérationnelle, les règles s’accumulaient continuellement, finissant par former une « montagne de dette stratégique » difficile à maintenir, entravant gravement la flexibilité du système et son efficacité de réponse.

Ensuite, les techniques d’apprentissage automatique ont fait passer la gestion des risques vers une nouvelle phase de reconnaissance statistique des motifs : grâce à l’ingénierie des caractéristiques et aux algorithmes d’apprentissage supervisé, elles permettent d’attribuer des scores de risque et de classifier les comportements, améliorant significativement la couverture de détection des risques. Toutefois, ce modèle dépend fortement des données historiques étiquetées et de la stabilité de leur distribution, souffrant typiquement du problème de « dérive de distribution » — c’est-à-dire que les régularités tirées des données historiques utilisées pour entraîner le modèle deviennent obsolètes dans la pratique en raison de changements de l’environnement de marché ou de l’évolution des techniques d’attaque, provoquant une chute importante de la précision du modèle (en d’autres termes, l’expérience passée n’est plus applicable). Dès qu’un attaquant modifie son chemin d’attaque, effectue un transfert interchaîne ou fractionne les fonds de manière plus fine, le modèle affiche des biais manifestes dans ses jugements.

L’apparition des grands modèles et des agents IA a apporté une révolution dans ce domaine. L’avantage fondamental des agents IA ne réside pas uniquement dans le fait d’être « plus intelligents » — avec des capacités cognitives et de raisonnement accrues — mais surtout dans le fait d’être « plus capables » — dotés d’une capacité complète d’orchestration et d’exécution des processus. Ils élèvent la gestion des risques d’une prédiction ponctuelle traditionnelle à une gestion fermée de bout en bout, incluant notamment : l’identification de signaux anormaux, le complément de preuves associées, la corrélation avec des adresses pertinentes, la compréhension de la logique comportementale des contrats, l’évaluation de l’exposition au risque, la génération de recommandations de traitement ciblées, le déclenchement d’actions de contrôle, et la production d’un registre vérifiable. Autrement dit, l’IA a évolué du stade « vous indiquer qu’un problème est susceptible d’exister » à celui de « vous aider à porter le problème à un état actionnable ».

Cette évolution est tout aussi remarquable côté trading : on passe d’une approche traditionnelle fondée sur la lecture manuelle de rapports, l’analyse d’indicateurs et la rédaction de stratégies, à une automatisation intégrale où l’IA récupère automatiquement des données provenant de multiples sources, génère spontanément des stratégies de trading, exécute les ordres automatiquement, puis procède à un réexamen et à une optimisation automatiques. La chaîne d’actions du système s’approche de plus en plus d’un « système décisionnel autonome ».

Toutefois, il convient de rester vigilant : une fois entré dans le paradigme du système décisionnel autonome, le risque s’accroît également. Les erreurs humaines sont généralement peu fréquentes et non uniformes ; tandis que les erreurs machines tendent à être fréquentes, reproductibles, et susceptibles d’être déclenchées à grande échelle, simultanément. C’est précisément pourquoi le véritable défi posé par l’application de l’IA dans les systèmes financiers ne réside pas dans la question « peut-on le faire ? », mais dans celle-ci : « peut-on le faire dans des limites contrôlables ? ». Ces limites comprennent notamment une portée d’autorisation claire, des plafonds de montants, une liste définie de contrats pouvant être appelés, ainsi que la possibilité pour le système de se dégrader automatiquement ou de freiner d’urgence en cas de risque. Ce problème est encore amplifié dans le domaine Web3, principalement en raison de l’irréversibilité des transactions sur chaîne — une fois qu’une erreur ou une attaque survient, les pertes financières sont souvent irrémédiables.

2. L’effet d’amplification de la structure technologique du Web3 sur l’application de l’IA : ouvert, composable, irréversible

Lorsque l’IA évolue du statut « d’outil d’assistance » à celui de « système décisionnel autonome », une question cruciale émerge : quelle réaction chimique cette évolution produit-elle lorsqu’elle s’associe au Web3 ? La réponse est la suivante : la structure technologique du Web3 amplifie à la fois les avantages d’efficacité et les risques potentiels de l’IA — elle permet non seulement une amélioration exponentielle de l’efficacité des transactions automatisées, mais étend aussi de façon notable la portée et la gravité des risques potentiels. Cet effet d’amplification provient de la combinaison des trois caractéristiques structurelles du Web3 : données publiques, compositionnalité des protocoles, et règlement irréversible.

Du point de vue des avantages, l’attractivité fondamentale du Web3 pour l’IA provient d’abord du niveau des données. Les données sur chaîne sont naturellement publiques, transparentes, vérifiables et traçables, offrant ainsi aux fonctions de gestion des risques et de conformité un avantage en matière de transparence inaccessible dans la finance traditionnelle — il est possible de visualiser clairement, sur un grand livre unique, la trajectoire des fonds, les itinéraires d’interaction interprotocole, ainsi que les processus de fractionnement et de consolidation des fonds.

Toutefois, les données sur chaîne présentent également une difficulté significative de compréhension : les adresses sont « sémantiquement pauvres » (c’est-à-dire qu’elles ne disposent pas d’une identité explicite et ne peuvent pas être directement reliées à des entités réelles), les données parasites sont nombreuses, et les données interchaînes sont fortement fragmentées. Lorsque les comportements commerciaux réels s’emmêlent avec ceux destinés à dissimuler l’origine des fonds, il devient très difficile de distinguer efficacement les deux uniquement à l’aide de règles simples. Cela fait de la compréhension des données sur chaîne une tâche à forte intensité de ressources : il faut fusionner de manière approfondie les séquences de transactions, la logique des appels de contrats, les messages interchaînes et les renseignements hors chaîne pour aboutir à des conclusions explicites et fiables.

L’impact le plus crucial provient de la compositionnalité et de l’irréversibilité du Web3. La compositionnalité des protocoles accélère considérablement l’innovation financière : une stratégie de trading peut être assemblée de façon flexible, à l’instar de briques LEGO, combinant des modules tels que le prêt, les bourses décentralisées (DEX), les produits dérivés et les ponts interchaînes, afin de créer de nouveaux produits et services financiers. Mais cette caractéristique accélère également la propagation des risques : un petit défaut dans un composant peut s’amplifier rapidement le long de la « chaîne d’approvisionnement » (terme préféré à « chaîne de dépendances » pour faciliter la compréhension large de la transmission des risques) et même être immédiatement réutilisé par des attaquants comme modèle d’attaque.

Quant à l’irréversibilité, elle rend la gestion post-facto extrêmement difficile. Dans les systèmes financiers traditionnels, lorsqu’une transaction erronée ou une fraude survient, il est encore possible de faire appel à l’annulation de la transaction, au refus de paiement ou à des mécanismes de compensation entre institutions pour limiter les pertes. Dans le domaine Web3, dès que les fonds sont transférés interchaînes, entrent dans un service de mélange (« Mixing Service ») ou se dispersent rapidement vers un grand nombre d’adresses, la difficulté de les retrouver augmente de façon géométrique. Cette caractéristique pousse le secteur à déplacer le centre de gravité de la sécurité et de la gestion des risques de la « justification post-facto » traditionnelle vers une « alerte préventive et une interception en temps réel » — seule une intervention avant ou pendant la survenue du risque peut efficacement réduire les pertes.

3. Voies d’intégration différenciées entre les plateformes centralisées (CEX) et la finance décentralisée (DeFi) : une même IA, des surfaces de contrôle différentes

Après avoir compris l’effet d’amplification de la structure technologique du Web3, nous devons faire face à une réalité : bien que l’IA soit introduite dans les deux cas, les points d’application des plateformes centralisées (CEX) et des protocoles de finance décentralisée (DeFi) ne sont pas identiques, la raison fondamentale étant la différence essentielle entre leurs « surfaces de contrôle » (terme issu de l’ingénierie réseau, désignant ici la capacité d’intervenir sur les fonds et les protocoles).

Même lorsqu’elle est appliquée au trading et à la gestion des risques, l’IA est mise en œuvre différemment selon qu’il s’agit d’un CEX ou d’un protocole DeFi. Un CEX dispose d’un système complet de comptes et d’une surface de contrôle forte, lui permettant donc de mettre en œuvre des vérifications KYC (Know Your Customer) / KYB (Know Your Business), d’établir des limites de transaction, et de créer des mécanismes de traitement formalisés tels que le gel ou le retour arrière des transactions. La valeur ajoutée de l’IA dans un CEX se manifeste généralement sous la forme d’un examen plus efficace, d’une détection plus rapide des transactions suspectes, et d’une génération plus automatisée de documents de conformité et de registres d’audit.

En revanche, les protocoles DeFi, en raison de leur caractère décentralisé fondamental, disposent de moyens d’intervention (surface de contrôle) relativement limités : ils ne peuvent pas geler directement les comptes des utilisateurs comme le ferait un CEX. Ils constituent plutôt un environnement ouvert caractérisé par une « faible surface de contrôle + forte compositionnalité ». La plupart des protocoles DeFi ne possèdent pas intrinsèquement la capacité de geler des fonds ; les points réels de contrôle des risques sont dispersés sur plusieurs nœuds, notamment les interfaces frontales, la couche d’API, les étapes d’autorisation des portefeuilles, ainsi que les couches intermédiaires de conformité (par exemple, les API de gestion des risques, les listes d’adresses à risque, les réseaux de surveillance et d’alerte sur chaîne).

Cela signifie que l’application de l’IA dans le domaine DeFi met davantage l’accent sur les capacités de compréhension et d’alerte en temps réel, notamment la détection précoce de parcours de transaction anormaux, l’identification précoce des expositions au risque en aval, et la diffusion rapide des signaux de risque vers les nœuds disposant d’un pouvoir de contrôle effectif (tels que les plateformes d’échange, les émetteurs de stablecoins, les partenaires chargés de l’application de la loi ou les instances de gouvernance des protocoles) — par exemple, Tokenlon effectue un balayage KYA (Know Your Address) sur les adresses initiant les transactions et refuse directement les services aux adresses figurant sur des listes noires connues, permettant ainsi d’intercepter et de bloquer les fonds avant qu’ils n’atteignent des zones incontrôlables.

D’un point de vue de mise en œuvre technique, cette différence de surface de contrôle détermine la forme concrète des capacités IA : dans un CEX, l’IA ressemble davantage à un système décisionnel et opérationnel automatisé à haut débit, dont l’objectif principal est d’améliorer l’efficacité et la précision des processus existants ; tandis que dans un environnement DeFi, l’IA ressemble davantage à un système continu de perception de la situation sur chaîne et de diffusion de renseignements, dont l’objectif central est de détecter précocement les risques et d’y répondre rapidement. Bien que les deux évoluent vers une architecture d’agents, leurs mécanismes de contrainte diffèrent nettement : dans le cas des CEX, les contraintes proviennent davantage des règles internes et de la gestion des autorisations de compte, tandis que dans le cas de la DeFi, elles reposent davantage sur l’autorisation programmable, la validation par simulation des transactions, et la gestion par liste blanche des plages de contrats pouvant être appelés.

4. Agents IA, protocole x402 et formation du système transactionnel exécutable par machine : de Bot à Réseau d’Agents

Les robots de trading (bots) d’antan étaient souvent de simples combinaisons de stratégies et d’interfaces fixes, avec une logique d’automatisation relativement rudimentaire ; les agents IA, quant à eux, ressemblent davantage à des exécutants généralisables — capables de sélectionner autonomement des outils, d’orchestrer les étapes d’exécution et de s’auto-corriger et s’optimiser sur la base des retours. Toutefois, pour qu’un agent IA acquière réellement des capacités économiques complètes, deux conditions essentielles sont indispensables : premièrement, une autorisation programmable explicite et des limites claires en matière de gestion des risques ; deuxièmement, une interface de paiement et de règlement native pour les machines. L’apparition du protocole x402 satisfait précisément cette deuxième condition : en s’intégrant à la sémantique HTTP standard, il extrait la phase de paiement du flux d’interaction humaine, permettant ainsi au client (agent IA) et au serveur d’effectuer des transactions intermachines efficaces, sans nécessiter de compte, d’abonnement ou de clé API.

Une fois que les processus de paiement et d’appel sont standardisés, l’économie machine adoptera une nouvelle forme organisationnelle : les agents IA ne se limitent plus à exécuter des tâches ponctuelles, mais peuvent former, entre plusieurs services, une boucle continue de « paiement pour appel — obtention de données — génération de décisions — exécution de transactions ». Toutefois, cette standardisation rend également les risques standardisés : la standardisation des paiements favorise l’émergence d’activités frauduleuses automatisées et d’appels de services de blanchiment ; la standardisation de la génération de stratégies conduit à la diffusion de chemins d’attaque reproductibles.

Il convient donc de souligner la logique fondamentale suivante : l’intégration de l’IA au Web3 ne consiste pas simplement à connecter un modèle IA aux données sur chaîne, mais bien à une migration profonde de paradigme systémique. Plus précisément, les domaines des transactions et de la gestion des risques évoluent tous deux vers un mode « exécutable par machine » ; dans un monde exécutable par machine, il est impératif de construire une infrastructure complète permettant aux machines d’agir, d’être contraintes, d’être auditées et d’être arrêtées, sans quoi les gains d’efficacité seront totalement annulés par les pertes dues à la fuite des risques.

Chapitre 2 : Comment l’IA redéfinit l’efficacité des transactions Web3 et la logique décisionnelle

1. Défis structurels de l’environnement transactionnel Web3 et points d’entrée de l’IA

L’un des principaux défis structurels de l’environnement transactionnel Web3 est la fragmentation de la liquidité causée par la coexistence des bourses centralisées (CEX) et décentralisées (DEX) — la liquidité est dispersée entre différents lieux d’échange et différentes blockchains, ce qui fait que le « prix vu » par les utilisateurs ne coïncide souvent pas avec le « prix réellement exécutable » ni avec le volume réellement disponible. Dans ce scénario, l’IA joue un rôle clé de couche d’orchestration, capable, sur la base de multiples facteurs tels que la profondeur du marché, les coûts de glissement, les frais de transaction, les itinéraires de routage et la latence, de fournir aux utilisateurs des recommandations optimales concernant la répartition et l’exécution des ordres, améliorant ainsi efficacement l’efficacité des transactions.

La volatilité élevée, le risque élevé et l’asymétrie informationnelle des marchés cryptographiques persistent depuis longtemps, et sont encore exacerbés dans les mouvements de marché axés sur des événements. L’un des principaux atouts de l’IA pour atténuer ce problème réside dans l’élargissement de la couverture informationnelle — en regroupant et en analysant de façon structurée les annonces de projets, les données de trésorerie sur chaîne, les sentiments exprimés sur les réseaux sociaux et les documents d’études spécialisées, l’IA aide les utilisateurs à construire plus rapidement une compréhension fondamentale des bases des projets et de leurs points de risque potentiels, réduisant ainsi les biais décisionnels liés à l’asymétrie informationnelle.

L’utilisation de l’IA pour soutenir les transactions n’est pas nouvelle, mais son rôle évolue progressivement, passant de « l’aide à la lecture des informations » à des fonctions centrales telles que « l’identification des signaux — l’analyse des sentiments — la production de stratégies ». Par exemple, la détection en temps réel des flux de fonds anormaux et des transferts de fonds effectués par des « baleines », l’analyse quantitative des sentiments sur les réseaux sociaux et de la popularité narrative des projets, ou encore la classification automatique et les alertes concernant l’état du marché (tendance, consolidation, expansion de la volatilité) — toutes ces capacités trouvent plus facilement une application à grande échelle dans l’environnement Web3, caractérisé par des interactions informationnelles à haute fréquence.

Toutefois, il convient de rappeler simultanément les limites de l’application de l’IA : la validité des prix et la qualité de l’information sur les marchés cryptographiques demeurent instables. Si les données brutes traitées par l’IA contiennent du bruit, sont manipulées ou font l’objet d’une mauvaise attribution, cela entraîne le phénomène classique du « garbage in, garbage out » (des données erronées en entrée produisent des résultats erronés en sortie). Ainsi, lors de l’évaluation des signaux de trading générés par l’IA, la fiabilité des sources d’information, l’intégrité de la chaîne de preuves logiques, l’expression explicite du degré de confiance et la possibilité de vérification contre-factuelle (c’est-à-dire si le signal peut être croisé et validé sur plusieurs dimensions) sont plus importantes que la « force du signal » en soi.

2. Formes industrielles et orientations évolutives des outils IA pour le trading Web3

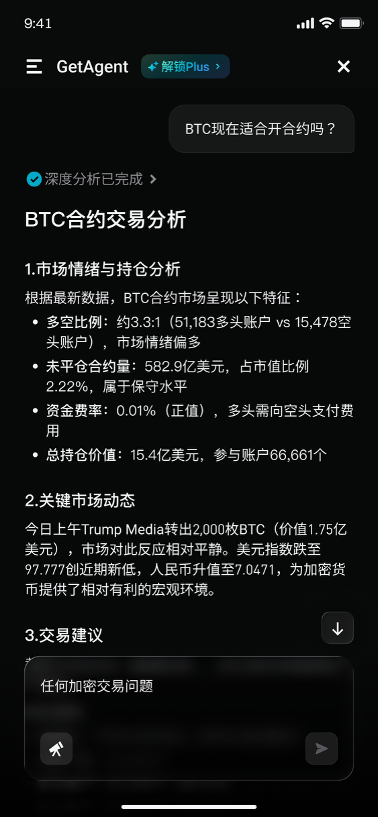

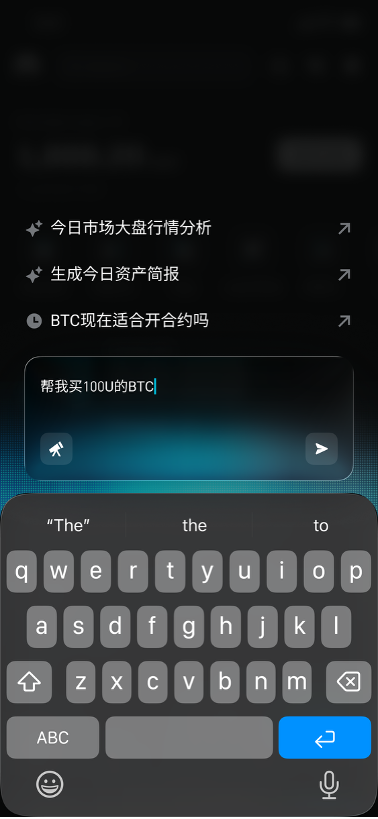

Actuellement, l’évolution des outils IA intégrés aux bourses va de l’interprétation traditionnelle des cotations vers une assistance complète à l’ensemble du processus transactionnel, mettant davantage l’accent sur une vision unifiée de l’information et sur l’efficacité de sa diffusion. Prenons l’exemple de GetAgent, lancé par Bitget : son positionnement est davantage celui d’un outil généraliste d’assistance aux informations transactionnelles et aux conseils d’investissement. En présentant les variables clés du marché, les points de risque potentiels et les éléments d’information essentiels de façon plus accessible, il réduit efficacement les barrières liées à l’accès à l’information et à la compréhension technique.

Les bots sur chaîne et le copy trading (copie des transactions) représentent la tendance à la diffusion de l’automatisation côté exécution : leur principal avantage réside dans la transformation des stratégies professionnelles en processus d’exécution standardisés et reproductibles, abaissant ainsi le seuil d’accès au trading pour les utilisateurs ordinaires. À l’avenir, un objet de copie pourrait très bien provenir d’une équipe de trading quantitatif ou d’un fournisseur de stratégies systématisées basé sur l’IA. Cela transformera toutefois la question de la « qualité des stratégies » en un problème plus complexe de « durabilité et d’explicabilité des stratégies » — les utilisateurs doivent non seulement connaître les performances passées de la stratégie, mais aussi comprendre sa logique sous-jacente, ses scénarios d’application et ses risques potentiels.

Il convient de surveiller attentivement les questions de capacité du marché et de saturation stratégique : lorsque de nombreux capitaux agissent simultanément sur des signaux similaires et selon des logiques d’exécution semblables, les rendements des transactions sont rapidement comprimés, tandis que les coûts de chocs de marché et l’amplitude des replis de capitaux augmentent sensiblement. En particulier dans l’environnement des transactions sur chaîne, les fluctuations de glissement, l’influence de la MEV (valeur maximale extractible), l’incertitude des itinéraires de routage et les variations instantanées de liquidité amplifient encore davantage les effets externes négatifs des « transactions congestionnées », faisant que les rendements réels restent largement inférieurs aux attentes.

Par conséquent, une conclusion plus neutre et rationnelle est la suivante : plus la forme des outils de trading IA évolue vers l’automatisation, plus il est nécessaire de discuter conjointement de leurs capacités et de leurs mécanismes de contrainte. Ces mécanismes comprennent notamment des conditions d’application explicites des stratégies, des plafonds stricts de risque, des règles d’arrêt automatique en cas de scénarios anormaux, ainsi que la capacité d’auditabilité des sources de données et du processus de génération des signaux. Sans cela, « l’amélioration de l’efficacité » pourrait elle-même devenir un canal d’amplification des risques, causant des pertes inutiles aux utilisateurs.

3. Positionnement de Bitget GetAgent dans l’écosystème IA du trading

Le positionnement de GetAgent ne se limite pas à celui d’un simple robot conversationnel, mais vise à devenir le « deuxième cerveau » du trader dans un environnement de liquidité complexe. Sa logique centrale repose sur une fusion approfondie entre les algorithmes IA et les données multidimensionnelles en temps réel, afin de construire une boucle complète reliant données, stratégies et exécution. Sa valeur ajoutée se manifeste principalement sur quatre niveaux :

(1) Suivi des actualités et des données en temps réel

La surveillance traditionnelle des actualités et l’analyse des données exigent des compétences élevées en matière de crawl et d’analyse, constituant une barrière élevée pour les utilisateurs. Grâce à l’intégration de plus de 50 outils professionnels, GetAgent permet une « pénétration en temps réel » de la « boîte noire » du marché — il surveille non seulement en temps réel les dynamiques des principaux médias financiers, mais pénètre également en profondeur dans les sentiments exprimés sur les réseaux sociaux, les actualités essentielles des équipes projet, etc., garantissant ainsi que les utilisateurs n’ont aucune zone aveugle dans leur acquisition d’information.

En outre, GetAgent dispose d’une puissante capacité de filtrage et d’extraction d’informations, capable d’éliminer efficacement les bruits inutiles tels que le marketing des jetons sans valeur (« shitcoins »), et d’extraire avec précision les variables fondamentales influençant effectivement les fluctuations de prix, comme les alertes de vulnérabilités de sécurité des projets ou les plans de déverrouillage massif de jetons. Enfin, GetAgent intègre et analyse les flux de transactions sur chaîne, fragmentés, ainsi que les milliers d’annonces et de rapports disponibles, pour les transformer en jugements logiques intuitifs — par exemple, il informe directement l’utilisateur que « bien que l’engouement sur les réseaux sociaux autour de ce projet soit élevé, les fonds des développeurs clés fuient continuellement », rendant ainsi les risques potentiels parfaitement visibles.

(2) Génération de stratégies de trading et assistance à l’exécution

GetAgent peut générer des stratégies de trading personnalisées en fonction des besoins individuels de l’utilisateur, réduisant ainsi considérablement le seuil d’exécution des transactions et faisant évoluer la prise de décision transactionnelle d’une approche « guidée par des instructions professionnelles » vers une approche « guidée par l’intention et la stratégie » précise. En tenant compte des préférences historiques de trading de l’utilisateur, de sa tolérance au risque et de sa situation actuelle de positions, GetAgent ne fournit pas de conseils génériques sur les marchés haussiers ou baissiers, mais des recommandations hautement ciblées, telles que « pour votre position actuelle en BTC, il est conseillé de configurer une stratégie de trading en grille sur l’intervalle X-Y, compte tenu de la volatilité actuelle ».

Pour les opérations complexes impliquant plusieurs devises et plusieurs protocoles, GetAgent les simplifie en une interaction en langage naturel — l’utilisateur n’a besoin que d’exprimer son intention transactionnelle en langage courant, et GetAgent trouve automatiquement la meilleure stratégie en arrière-plan, tout en optimisant la profondeur du marché et le glissement, réduisant ainsi considérablement le seuil d’accès des utilisateurs ordinaires aux transactions complexes Web3.

(3) Relation de synergie avec le système de trading automatisé

GetAgent n’est pas un outil isolé, mais constitue le nœud décisionnel central de l’ensemble du système de trading automatisé. En amont, il reçoit des entrées multidimensionnelles provenant des données sur chaîne, des cotations en temps réel, des sentiments sur les réseaux sociaux et des informations issues d’études spécialisées ; après un traitement structuré interne, un résumé des informations clés et une analyse logique des corrélations, il établit un cadre systématique de jugement stratégique ; en aval, il fournit des références décisionnelles précises et des suggestions de paramètres aux systèmes de trading automatisés, aux agents IA quantitatifs et aux systèmes de copy trading, permettant ainsi une synergie coordonnée de l’ensemble du système.

(4) Risques et contraintes sous-jacents à l’amélioration de l’efficacité transactionnelle

En adoptant les gains d’efficacité apportés par l’IA, il est indispensable de rester extrêmement vigilant face aux risques potentiels. Quel que soit le caractère apparemment fort du signal de trading fourni par GetAgent, le principe fondamental « recommandation IA, confirmation humaine » doit être systématiquement respecté. Dans le cadre de ses recherches approfondies et de son amélioration continue des capacités IA, l’équipe Bitget ne cherche pas seulement à ce que GetAgent fournisse des recommandations de trading précises, mais explore également activement la possibilité de lui faire produire une chaîne complète de preuves logiques — pourquoi recommander ce point d’achat ? Est-ce dû à une convergence d’indicateurs techniques, ou à un afflux anormal de fonds provenant d’adresses « baleines » sur chaîne ?

Selon l’équipe Bitget, la valeur à long terme de GetAgent ne réside pas dans la fourniture de conclusions de trading déterministes, mais dans l’aide qu’il apporte aux traders et aux systèmes transactionnels pour mieux comprendre les types de risques qu’ils assument, et pour évaluer si ces risques correspondent bien à la phase actuelle du marché, afin de prendre des décisions transactionnelles plus rationnelles.

4. Équilibre entre efficacité transactionnelle et risque : le soutien sécuritaire de BlockSec

Derrière l’amélioration de l’efficacité des transactions pilotée par l’IA, la gestion des risques reste un enjeu central impossible à négliger. Fondé sur une compréhension approfondie des risques liés aux transactions Web3, BlockSec propose un soutien global en matière de sécurité, aidant les utilisateurs à bénéficier des commodités du trading IA tout en maîtrisant efficacement les risques potentiels :

Face aux risques de bruit dans les données et d’attribution erronée, Phalcon Explorer de BlockSec offre des fonctions puissantes de simulation de transactions et de vérification croisée multiforme, permettant de filtrer efficacement les données manipulées et les signaux erronés, et aidant les utilisateurs à identifier les véritables tendances du marché ;

Pour les risques de marché liés à la saturation des stratégies, la fonction de suivi des flux de fonds de MetaSleuth permet d’identifier en temps réel la concentration des fonds utilisant des stratégies similaires, anticipant ainsi les risques de panique liquide et fournissant des repères pour ajuster les stratégies de trading ;

En ce qui concerne la sécurité de la chaîne d’exécution, la fonction Approval Diagnosis (diagnostic d’autorisation) de MetaSuites détecte en temps réel les comportements d’autorisation anormaux et permet aux utilisateurs d’annuler d’un seul clic les autorisations à haut risque, prévenant efficacement les pertes de fonds dues à une utilisation abusive des autorisations ou à des exécutions erronées.

Chapitre 3 : Évolution de la cyberguerre Web3 et nouveau paradigme de sécurité à l’ère de l’IA

Alors que la technologie IA accélère l’efficacité des transactions, elle rend également les attaques plus rapides, plus cachées et plus destructrices. L’architecture décentralisée du Web3 entraîne une dispersion naturelle des responsabilités, la compositionnalité des contrats intelligents confère aux risques une caractéristique d’externalité systémique, et la généralisation des grands modèles réduit encore davantage le seuil technique pour la compréhension des vulnérabilités et la génération des chemins d’attaque, propulsant les attaques vers une automatisation et une industrialisation complètes.

En contrepartie, la défense sécuritaire doit évoluer depuis la détection traditionnelle « plus performante » vers une « boucle de traitement en temps réel exécutable », et, dans le contexte spécifique des transactions exécutées par machine, procéder à une ingénierie rigoureuse de la gestion des autorisations, de la prévention des exécutions erronées et des risques systémiques en cascade, afin de construire un nouveau paradigme de sécurité Web3 adapté à l’ère de l’IA.

1. La redéfinition par l’IA des méthodes d’attaque et des formes de risque dans le Web3

Le dilemme sécuritaire du Web3 ne réside jamais simplement dans la « présence ou non de vulnérabilités », mais surtout dans le fait que son architecture décentralisée disperse naturellement les responsabilités. Par exemple, le code du protocole est développé et publié par l’équipe projet, l’interface frontale peut être maintenue par une équipe différente, les transactions sont lancées via les portefeuilles et les protocoles de routage, les fonds circulent entre les DEX, les protocoles de prêt, les ponts interchaînes et les agrégateurs, et les entrées/sorties de fonds sont finalement réalisées via des plateformes centralisées — lorsqu’un incident de sécurité survient, chaque maillon peut affirmer ne détenir qu’une « surface de contrôle locale » et ne pas pouvoir assumer la responsabilité globale. Or, les attaquants exploitent précisément cette dispersion structurelle, tissant des liens entre plusieurs maillons faibles pour créer une situation où aucun acteur ne peut exercer un contrôle global, atteignant ainsi leur objectif.

L’introduction de l’IA accentue encore davantage cette faiblesse structurelle. Les chemins d’attaque peuvent être recherchés, générés et réutilisés de façon systématique par les systèmes IA, et la vitesse de diffusion des risques dépasse pour la première fois de façon stable la vitesse maximale de coordination humaine, rendant inefficaces les mécanismes traditionnels de réponse d’urgence. Au niveau des contrats intelligents, les risques systémiques liés aux vulnérabilités ne sont pas une exagération. La compositionnalité de la DeFi permet à un petit défaut de code de s’amplifier rapidement le long des relations de dépendance, pour finalement se transformer en accident de sécurité à l’échelle de l’écosystème, tandis que le caractère irréversible du règlement des fonds réduit la fenêtre temporelle de réponse d’urgence à quelques minutes.

Selon le tableau de bord des incidents de sécurité DeFi maintenu par BlockSec, le montant total des fonds volés dans le domaine cryptographique en 2024, suite à des attaques de pirates et à l’exploitation de vulnérabilités, a dépassé 2 milliards de dollars américains, les protocoles DeFi restant les principales cibles. Ces chiffres démontrent clairement que, même si les investissements du secteur dans la sécurité augmentent continuellement, les incidents d’attaque se produisent toujours fréquemment, avec des pertes unitaires élevées et une destructivité forte. Lorsque les contrats intelligents deviennent un composant central des infrastructures financières, les vulnérabilités ne sont plus de simples défauts techniques, mais ressemblent davantage à des risques financiers systémiques pouvant être exploités à des fins malveillantes.

La redéfinition par l’IA de la surface d’attaque se manifeste également dans la transition complète vers l’automatisation des étapes d’attaque auparavant tributaires de l’expérience humaine et des opérations manuelles :

La première catégorie concerne l’automatisation de l’exploration et de la compréhension des vulnérabilités. Les grands modèles possèdent des capacités remarquables de lecture de code, d’inférence sémantique et de raisonnement logique, leur permettant d’extraire rapidement des points faibles potentiels à partir de la logique complexe des contrats, et de générer avec précision les conditions de déclenchement des vulnérabilités, les séquences d’exécution des transactions et les combinaisons d’appels de contrats, réduisant considérablement le seuil technique pour exploiter les vulnérabilités.

La deuxième catégorie concerne l’automatisation de la génération des chemins d’attaque. Des recherches récentes dans le secteur commencent à transformer les modèles de langage volumineux (LLM) en générateurs de code d’exploitation (exploit) de bout en bout — en couplant les LLM avec des chaînes d’outils spécialisés, il est possible, à partir d’une adresse de contrat et d’une hauteur de bloc spécifiées, de collecter automatiquement les informations cibles, de comprendre la logique comportementale du contrat, de générer un contrat intelligent d’attaque compilable et exécutable, et de le tester et valider sur des états historiques de la blockchain. Cela signifie que les moyens d’attaque disponibles ne dépendent plus entièrement du débogage manuel réalisé par quelques chercheurs de sécurité de haut niveau, mais peuvent être ingénierisés en une chaîne d’attaque industrielle, pouvant être exécutée à grande échelle.

Des recherches plus larges en sécurité confirment également cette tendance : dans le cas d’une description donnée de CVE (vulnérabilités et expositions courantes), GPT-4 est capable, dans son jeu de tests, de générer une proportion très élevée de codes d’exploitation utilisables. Ce phénomène révèle une baisse rapide du seuil de passage de la description en langage naturel à un code d’attaque réel. Lorsque la génération de code d’attaque devient une capacité aussi aisément invoquable, la mise à l’échelle des attaques devient une réalité tangible.

L’effet d’amplification des attaques à grande échelle se manifeste typiquement dans le domaine Web3 de deux façons :

La première est l’attaque par « paradigme », c’est-à-dire que les attaquants utilisent une même stratégie d’attaque pour scanner, filtrer, tester et lancer des attaques en masse contre un grand nombre de contrats ayant une architecture similaire et présentant le même type de vulnérabilité sur l’ensemble du réseau (« attaque par paradigme » est préféré à « modèle unique, cibles multiples », car il correspond mieux à la terminologie professionnelle du secteur) ;

La deuxième est la « chaîne d’approvisionnement » du blanchiment de fonds et des escroqueries, ce qui dispense les malfaiteurs de devoir construire leur propre infrastructure complète. Par exemple, sur des plateformes comme Telegram, le marché noir chinois garanti a déjà constitué un marché de services criminels mature, où les plateformes illégales Huiwang Guarantee et Xinbi Guarantee, actives depuis 2021, ont facilité plus de 35 milliards de dollars américains de transactions en stablecoins, couvrant des activités telles que le blanchiment d’argent, la vente de données volées et d’autres services criminels plus graves. En outre, sur le marché noir Telegram, des outils d’escroquerie spécialisés, y compris des outils de deepfake, sont également commercialisés — cette offre de services criminels industrialisée signifie que les attaquants ne se contentent pas de générer plus rapidement des solutions d’exploitation et des chemins d’attaque, mais peuvent aussi obtenir rapidement des kits complets pour blanchir les fonds issus de leurs attaques, transformant ainsi un événement technique isolé en un événement complet de chaîne de valeur criminelle.

2. Le système de défense sécuritaire piloté par l’IA

Face à l’élévation des formes d’attaque induite par l’IA, la valeur fondamentale de l’IA dans le domaine de la défense réside dans la transformation des capacités sécuritaires traditionnellement tributaires de l’expérience humaine en systèmes ingénierie reproductibles et à grande échelle. Les capacités centrales de ce système de défense se manifestent sur trois niveaux :

(1) Analyse de code des contrats intelligents et audit automatisé

L’avantage fondamental de l’IA dans le domaine de l’audit des contrats intelligents réside dans la structuration et la systématisation des connaissances d’audit dispersées. Les outils traditionnels d’analyse statique et de vérification formelle excellent dans le traitement des règles déterministes, mais rencontrent souvent un dilemme entre faux négatifs et faux positifs lorsqu’ils doivent traiter une logique métier complexe, des appels multi-contrats ou des hypothèses implicites. En revanche, les grands modèles présentent des avantages évidents en matière d’interprétation sémantique, d’induction de motifs et de raisonnement logique inter-fichiers, ce qui les rend particulièrement adaptés comme étape préalable à l’audit, permettant une compréhension rapide du contrat et une alerte préliminaire sur les risques.

Toutefois, l’IA ne cherche pas à remplacer les outils d’audit traditionnels, mais plutôt à les intégrer dans une chaîne d’audit automatisée plus efficace. Concrètement, le modèle IA effectue d’abord un résumé sémantique du contrat, localise les points de risque suspects et émet des hypothèses sur les surfaces d’attaque potentielles, puis transmet ces informations aux outils d’analyse statique/analyse dynamique pour une vérification ciblée, et enfin, compile les résultats de vérification, la chaîne de preuves, les conditions de déclenchement des vulnérabilités et les recommandations de correction dans un rapport normalisé et vérifiable. Ce modèle de division des tâches — « l’IA pour la compréhension, les outils pour la vérification, l’humain pour la décision » — deviendra probablement la forme d’ingénierie la plus stable dans le domaine futur de l’audit des contrats intelligents.

(2) Détection des transactions anormales et des motifs comportementaux sur chaîne

Le travail central de l’IA dans ce domaine consiste à transformer les données sur chaîne, publiques mais désordonnées, en signaux de sécurité actionnables. La difficulté fondamentale du monde sur chaîne ne réside pas dans la rareté des données, mais dans la surcharge de données parasites : les transactions à haute fréquence par des robots, les transferts fractionnés de fonds, les sauts interchaînes, les routages complexes de contrats, etc., s’entrelacent, rendant les stratégies de seuils simples très fragiles et incapables d’identifier efficacement les anomalies.

Les technologies IA sont mieux adaptées à ce genre de scénarios complexes — grâce à la modélisation de séquences et à l’analyse de graphes, elles peuvent identifier avec précision les comportements précurseurs d’une attaque typique (par exemple, des opérations d’autorisation anormales, une densité inhabituelle d’appels de contrats, ou une corrélation indirecte avec des entités à risque connues), et calculer continuellement l’exposition au risque en aval, permettant ainsi aux équipes de sécurité de visualiser clairement la direction des flux de fonds, l’étendue potentielle des entités affectées, et la durée restante de

Bienvenue dans la communauté officielle TechFlow

Groupe Telegram :https://t.me/TechFlowDaily

Compte Twitter officiel :https://x.com/TechFlowPost

Compte Twitter anglais :https://x.com/BlockFlow_News