對話 0G Labs CEO:2 年內追平 Web2 AI,AI 公共產品的「零重力」實驗

TechFlow Selected深潮精選

對話 0G Labs CEO:2 年內追平 Web2 AI,AI 公共產品的「零重力」實驗

一起走進去中心化 AI 浪潮下,0G 的核心願景、技術實現路徑、生態著力點以及未來路線圖規劃。

撰文:深潮 TechFlow

OpenAI CEO Sam Altman 曾多次在播客及公開演講中表示:

AI 不是模型競賽,而是創造公共產品,實現人人受益,驅動全球經濟增長。

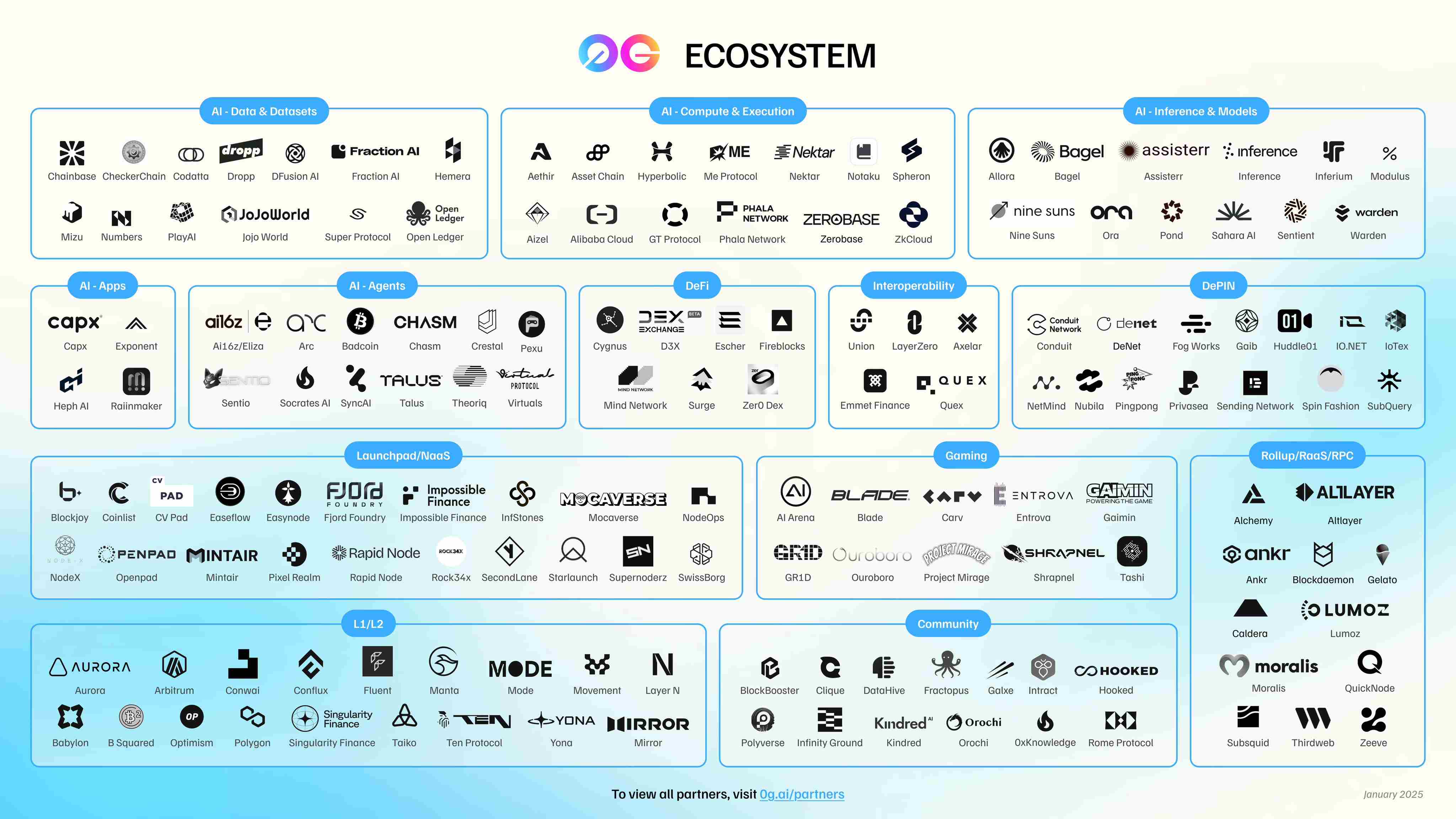

而在 Web2 AI 因寡頭壟斷而備受詬病的當下,以去中心化為精神內核的 Web3 世界,也有一個以「讓 AI 成為一種公共產品」為核心使命的項目,在成立兩年多的時間裡,斬獲 3500 萬美元融資,構建起支持 AI 創新應用發展的技術基礎,並吸引 300+ 生態合作伙伴,發展成為規模最大的去中心化 AI 生態之一。

它就是 0G Labs。

在與 0G Labs 聯合創始人兼 CEO Michael Heinrich 的深度對話中,「公共產品」的概念多次出現。談及對於 AI 公共產品的理解,Michael 分享道:

我們希望構建一種反中心化、反黑箱的 AI 發展模式,這種模式是透明、開放、安全以及普惠的,每個人都可以參與、貢獻數據與算力並獲得獎勵,社會整體能夠共享 AI 紅利。

而聊到如何實現,Michael 將 0G 的具體路徑一一拆解:

作為專為 AI 設計的 Layer 1,0G 擁有突出的性能優勢、模塊化設計以及無限擴展且可編程的 DA 層,從可驗證計算、多層存儲到不可篡改溯源層,構建一站式 AI 生態,為 AI 發展提供所有必要的關鍵組件。

本期內容,讓我們跟隨 Michael Heinrich 的分享,一起走進去中心化 AI 浪潮下,0G 的核心願景、技術實現路徑、生態著力點以及未來路線圖規劃。

普惠:「讓 AI 成為公共產品」的精神內核

深潮 TechFlow:感謝您的時間,首先歡迎您先做個自我介紹。

Michael:

大家好,我是 0G Labs 的聯合創始人兼 CEO Michael。

我是技術出身,曾在 Microsoft 和 SAP Labs 擔任工程師與技術產品經理等職位。後來我轉向了商業側,一開始我在一家遊戲公司工作,後來我加入了橋水基金負責投資組合構建相關工作,每天要審核約 600 億美元的交易。之後我選擇回到母校斯坦福繼續深造,並開啟了我第一次創業,後來這家公司獲得了風投支持並快速成長為獨角獸,團隊規模達 650 人,收入達 1 億美元,後來我選擇賣出該公司成功退出。

我與 0G 的淵源始於某一天,一位斯坦福的同學 Thomas 給我打電話,他對我說:

Michael,五年前我們一起投了好幾家加密公司(其中包括 Conflux),伍鳴(Conflux 與 0G 聯合創始人兼 CTO) 和 Fan Long(0G Labs 首席安全官) 是我支持過最優秀的工程師之一,他們想做一件可以全球擴展的事情。要不要見見他們?

在 Thomas 的牽線搭橋之下,我們四人經歷了 6 個月的聯合創始人溝通和磨合階段,期間我得出同樣結論:伍鳴和 Fan Long 是我共事過最出色的工程師兼計算機科學人才。我當時的想法是:我們必須立即開始。於是就有了 0G Labs。

0G Labs 成立於 2023 年 5 月,作為規模最大、速度最快的 AI Layer 1 平臺,我們構建了一個完整的去中心化的 AI 操作系統,並致力於將其打造為 AI 公共產品,該系統使所有 AI 應用程序都能夠完全去中心化的運行,這意味著執行環境是 L1 的一部分,不僅可以無限擴展到存儲,也可以擴展到計算網絡,包括推理、微調、預訓練等功能,支持任何 AI 創新應用的構建。

深潮 TechFlow:剛才您也提到,0G 匯聚了來自 Microsoft、Amazon、Bridgewater 等知名企業頂級人才,包括您在內的多名團隊成員此前在 AI、區塊鏈、高性能計算等領域都已取得突出成就。是什麼樣的信念及契機讓這樣一支「全明星團隊」共同選擇 All in 去中心化 AI 並加入 0G?

Michael:

促使我們一起做 0G 這個項目的原因很大程度上來源於項目的使命本身:讓 AI 成為一種公共產品,另一部分的動力則來源於我們對於 AI 發展現狀的擔憂。

中心化模式下,AI 可能被少數頭部公司壟斷並以黑箱的形式運行,你無法知道是誰標註了數據、數據來自何處、模型的權重與參數是什麼或者線上環境運行的到底是哪一個具體版本。一旦 AI 出問題,尤其是在自主 AI Agent 在網絡上執行大量操作的情況下,究竟由誰負責?更糟的是,中心化公司甚至可能失去對其模型的控制,從而導致 AI 徹底走向脫軌失控。

我們對這種走向感到擔心,因此我們希望構建一種反中心化、反黑箱的 AI 發展模式,這種模式是透明、開放、安全以及普惠的,我們稱其為「去中心化 AI 」。在這樣的體系中,每個人都可以參與、貢獻數據與算力並獲得公平獎勵。我們希望這種模式被打造成一種公共產品,社會整體能夠共享 AI 紅利。

深潮 TechFlow:「0G」這個項目名稱聽起來有點特別,0G 是 Zero Gravity 的縮寫,您可以介紹一下這個項目名稱的由來嗎?它如何體現了 0G 對去中心化 AI 未來的理解?

Michael:

其實我們的項目名稱來源於我們一直以來非常堅持的一個核心理念:

技術應當毫不費力、順暢無阻、無感順滑的,尤其是在構建基礎設施和後端技術時。也就是說,終端用戶不需要意識到自己正在使用 0G,只需感受產品所帶來的流暢體驗。

這就是 0G 項目名稱的由來:「Zero Gravity(零重力)」,在零重力環境裡,阻力被最小化,運動自然流暢,這正是我們想要帶給用戶的體驗。

同樣的,一切構建在 0G 之上的產品及應用都應傳遞同樣的「毫不費力」。舉個例子:假如你在一個視頻流媒體平臺看劇前,得先選服務器、再挑編碼算法、再手動設定支付網關,這將是一段極其糟糕且充滿摩擦的體驗。

而隨著 AI 的發展,我們認為這一切都將改變,比如你只需告訴一個 AI Agent「找出當前表現最好的某個 Meme 代幣,並買入 XX 數量」,該 AI Agent 即可自動調研表現、判斷是否真正有趨勢與價值、確認所在鏈、必要時跨鏈或橋接資產並完成購買。整個過程都無需用戶逐步手動執行。

消除摩擦,讓用戶輕鬆體驗,這就是 0G 要賦能的「零摩擦」未來。

社區驅動將徹底顛覆 AI 發展模式

深潮 TechFlow:在 Web3 AI 發展與 Web2 AI 相比仍有較大差距的現實情況下,為什麼說 AI 想要取得下一階段的突破性發展離不開去中心化力量?

Michael:

在參加今年的 WebX 盛會中一場圓桌活動時,有一位嘉賓給我留下深刻印象,這位嘉賓在 Google DeepMind 擁有 15 年工作經歷。

我們一致認為:AI 的未來將屬於由多個更小、更專長的語言模型構成的網絡,它們依然具備「大模型」級能力,當這些各有專長的小型語言模型通過路由、角色分工與激勵對齊被精細編排後,能在準確性、適應速度、成本效率與升級迭代速度上,超越單一的巨型單體模型。

原因在於:高價值訓練數據絕大多數並不公開,而是深藏在私有代碼庫、內部 Wiki、個人筆記本、加密存儲中。超過 90% 的細分領域專業化知識被鎖住,而且與個人經驗強綁定。而在沒有充足的驅動因素下,絕大多數人沒有動力免費交出這些專有知識削弱自身經濟利益。

但社區驅動的激勵模式能夠改變這一切,比如:我組織我的 ML 程序員朋友一起訓練一個精通 Solidity 的模型,他們貢獻代碼片段、調試記錄、算力與標註,並因貢獻獲得代幣獎勵,且模型日後在生產環境被調用時,他們還可持續按使用量獲得回報。

我們相信這就是人工智能的未來:在這種模式下,社區提供分佈式算力與數據,大大降低了 AI 門檻並減少對超級規模的中心化數據中心的依賴,從而進一步提升整體 AI 系統的韌性。

我們相信,這種分佈式的發展模式會讓 AI 發展更快,促使 AI 更高效的走向 AGI。

深潮 TechFlow:有社區成員將 0G 與 AI 的關係類比為 Solana 與 DeFi,您如何看待這一類比?

Michael:

我們非常開心能看到這種比較,因為將我們與諸如 Solana 這樣行業領先的項目做對照組,對於我們來說是一種鼓勵和鞭策。當然,站在長期發展角度,我們希望未來我們能建立起自己的獨特社區文化與品牌印象,讓 0G 以自身實力被直接認知,屆時當談及 AI 領域提到 0G 本身就已足夠,不再需要類比。

在 0G 的未來核心戰略上,我們計劃逐步挑戰更多封閉的中心化黑箱型公司,為此我們還需要進一步夯實基礎設施,具體來說未來我們還將持續聚焦行業研究與硬核工程,這是一項長期且富有挑戰的工作,極端情況下我們將花費兩年時間,但從目前的進度來看,或許一年時間我們就能完成。

舉例來說,據我們所知,我們是第一個在完全去中心化環境中成功訓練出 1070 億參數 AI 模型的項目,這一突破性進展約為此前公開紀錄的 3 倍,充分體現了我們在研究與執行兩方面的領先能力。

回到社區談到的 Solana 類比:Solana 早期在高吞吐區塊鏈性能上開創先河,0G 也希望在 AI 方面開創更多先河。

一站式 AI 生態核心技術組件

深潮 TechFlow:作為專為 AI 設計的 Layer 1,站在技術角度,0G 有哪些其他 Layer 1 沒有的功能或優勢?它們如何賦能 AI 發展?

Michael:

我認為 0G 作為專為 AI 設計的 Layer 1,其首個獨特優勢在於性能。

把 AI 搬到鏈上,很大程度上意味著需要處理極端的工作負載。舉個例子:現代 AI 數據中心的數據吞吐量從每秒數百 GB 到數 TB 不等,但 Serum 剛起步時的性能大約每秒 80 KB,幾乎比 AI 工作負載所需的性能低了百萬倍。因此我們設計了一個數據可用性層,通過引入網絡節點與共識機制,從而為任何 AI 應用程序提供無限的數據吞吐量。

我們還採用了分片設計,大規模的 AI 應用可以橫向增加分片提高總體吞吐,從而有效的實現每秒無限的交易處理,這樣的設計使得 0G 能夠滿足不同需要下的任何工作負載,從而更好的支持 AI 創新發展。

另外,模塊化設計是 0G 的另一個顯著特徵:您可以利用 Layer 1,可以單獨使用存儲層,也可以單獨使用計算層。它們單獨可用,組合後更能形成強大協同效應。比如要訓練一個 1000 億參數模型(100B),可以把訓練數據存在存儲層,通過 0G 計算網絡執行預訓練或微調,再把數據集哈希、權重哈希等不可篡改證明錨定在 Layer 1 上。也可只採用其中一個組件。模塊化設計讓開發者按需取用,同時保留可審計性與可擴展性,這賦予了 0G 支持各種用例的能力,非常強大。

深潮 TechFlow:0G 打造了一個無限擴展且可編程的 DA 層,能否向大家詳細介紹這是如何實現的?又如何賦能 AI 發展?

Michael:

讓我們從技術角度解釋這一突破是如何實現的。

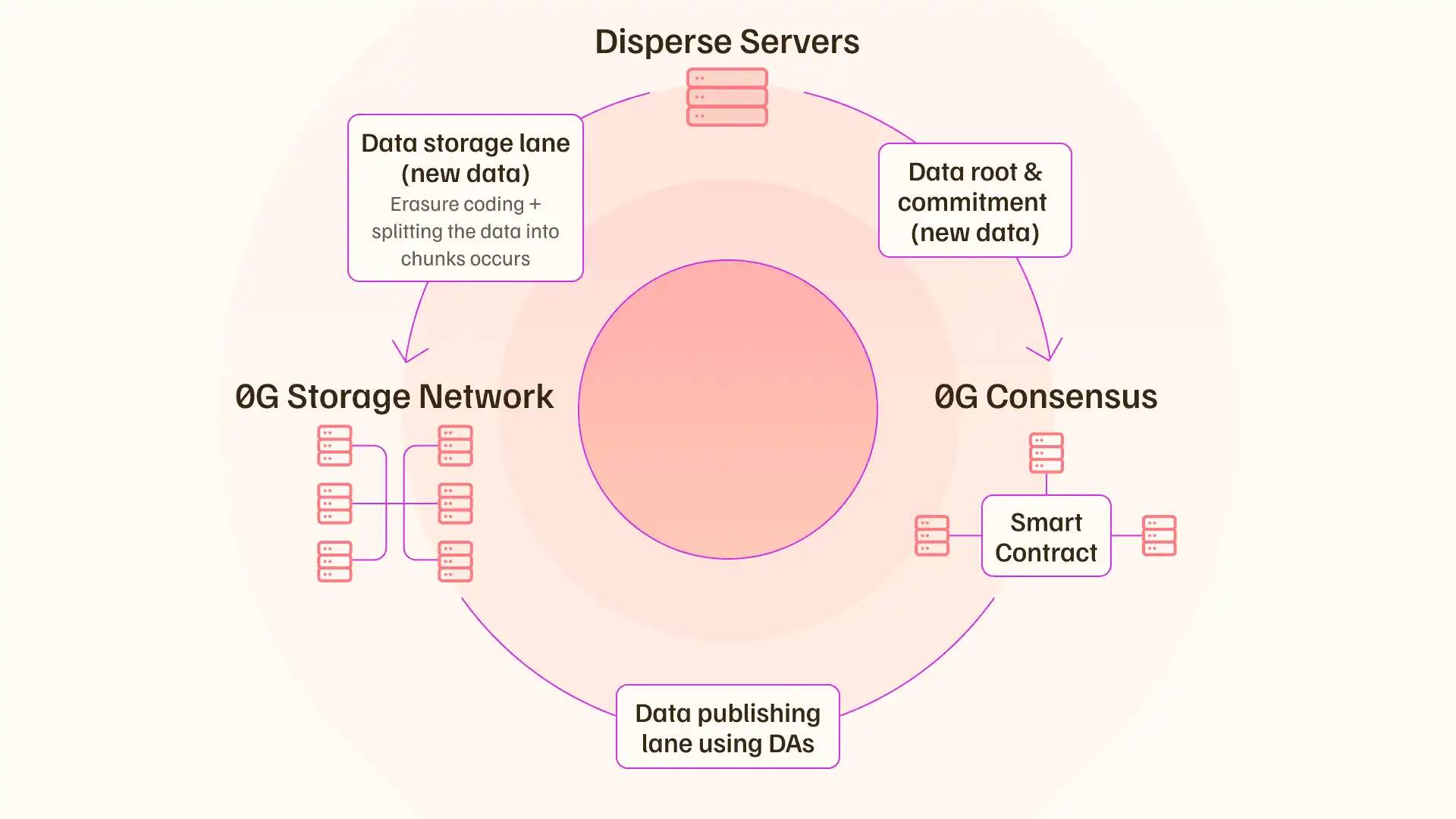

總的來說,核心突破包含兩部分:系統化並行;將「數據發佈路徑」與「數據存儲路徑」徹底拆分。如此一來,則能有效規避全網廣播瓶頸。

傳統的 DA 層設計會把完整數據塊(Blob)推送給所有驗證者,然後每個驗證者執行相同的計算,進行可用性採樣確定數據可用性。這非常低效,成倍消耗帶寬,形成廣播瓶頸。

因此,0G 採用糾刪碼設計,將一個數據塊拆分成大量分片並進行編碼,比如說將一個數據塊拆分為 3000 個分片,然後分片在各存儲節點中進行單次存儲,不向所有共識節點重複推送原始大文件。全網只廣播精簡的加密承諾(如 KZG commitment)與少量元數據。

然後,系統會在存儲節點和 DA 節點之間創建一個隨機表單用於收集簽名,隨機/輪換委員會對分片採樣或核驗包含證明,並聚合簽名聲明「數據可用性條件成立」。僅承諾 + 聚合簽名進入共識排序,極小化粗粒度數據在共識通道中的流量。

如此一來,由於全網流動的是輕量承諾與簽名而非完整數據,新增存儲節點即可增加整體寫入 / 服務能力,舉個例子,每個節點每秒的吞吐量大約為 35 M,理想情況下 N 個節點的理想總吞吐 ≈ N × 35 MB/s,吞吐近似線性擴展,直到新瓶頸出現。

而當瓶頸出現時,可以利用再質押的特性,保持相同的質押狀態,並同時啟動任意數量的共識層,有效的實現任意大規模工作負載的擴展。當再遇到瓶頸,如此循環,實現數據吞吐量的無限可擴展性。

深潮 TechFlow:如何理解 0G 的「一站式 AI 生態」願景?這裡的「一站式」具體可拆分為幾個核心組件?

Michael:

沒錯,我們希望提供所有必要的關鍵組件,以幫助大家在鏈上構建任何想要的 AI 應用。

這一願景具體可拆分為幾個層面:一是可驗證計算;二是多層存儲;三是把兩者綁定到一起的不可篡改溯源層。

在計算與可驗證性方面,開發者需要證明某個明確的計算在指定輸入上被正確執行。當前我們採用 TEE(可信執行環境)解決方案,通過硬件隔離提供機密性與完整性,驗證計算的發生。

一旦驗證通過,你就可以在鏈上創建一條不可篡改的記錄,表明針對特定類型的輸入已經完成了特定的計算,且任何後續參與方都能校驗,在這個去中心化運作系統中,你不必再嘗試去相信誰。

在存儲層面,AI Agent、訓練 / 推理工作流需要多樣數據行為,而 0G 提供適配多種 AI 數據形態的存儲,您可以擁有長期存儲,或者更難的存儲形式。比如,如果你需要非常快速地為代理交換內存,那麼您可以選擇一種更難的存儲形式,能夠支持 Agent 記憶、會話狀態等的高速讀寫與快速換入換出,而不僅僅是日誌追加類型的存儲。

與此同時,0G 原生提供兩類存儲層級,省去多家數據供應商交互之間的摩擦。

總的來說,我們設計了一切,包括 TEE 驅動可驗證計算、分層存儲、鏈上溯源模塊,幫助開發者可以專注於業務與模型邏輯,而不需要為了搭建基本的信任保障去東拼西湊,一切在 0G 提供的一體化棧中都能得到解決。

從 300+ 合作伙伴到 8880 萬美元生態基金:打造規模最大的去中心化 AI 生態

深潮 TechFlow:目前 0G 擁有 300+ 生態合作伙伴,已成為規模最大的去中心化 AI 生態之一。站在生態角度,0G 生態的AI use cases 有哪些? 有哪些生態項目值得關注

Michael:

經過積極的建設工作,目前 0G 生態規模漸起,涵蓋從基礎的計算供給側,到豐富的面向用戶的 AI 應用的多方維度。

在供給側,一些需要大量 GPU 以支撐密集工作負載的 AI 開發者可以直接利用去中心化計算網絡 Aethir、Akash 資源,而不必再與中心化資源反覆博弈。

而在應用側,0G 生態 AI 項目表現出高度多樣性,比如:

HAiO 是一個 AI 音樂生成平臺,可以根據天氣、心情、時間等因素創作由 AI 生成的歌曲,而且歌曲質量非常高,這非常了不起;Dormint 通過 0G 的去中心化 GPU 和低成本存儲,對用戶的健康數據進行跟蹤,並移除個性化建議,讓健康管理不再枯燥;Balkeum Labs 則是一個隱私至上的 AI 訓練,支持多方在不暴露原始數據的前提下協同訓練模型;Blade Games 是一個圍繞 zkVM 堆棧構建的鏈上游戲 + AI Agent 生態系統,正計劃把鏈上 AI 驅動的 NPC 引入遊戲;以及 Beacon Protocol,致力於提供額外的數據與 AI 隱私保護等。

隨著底層棧趨於穩定,0G 生態更多垂直場景正持續湧現,一個特別的方向就是「AI Agnet 與其資產化」。對此我們推出了首個去中心化 iNFT 交易市場 AIverse,這是我們提出的新標準。我們設計了一種方法,將 Agent 的私鑰嵌入到 NFT 元數據中,實現 iNFT 的持有者擁有對該 Agent 的所有權,AIverse 允許交易這些 iNFT 資產,即使 Agent 正在產生一定內在價值,這很大程度上補齊自主代理歸屬與可轉移問題的缺口。One Gravity NFT 持有者能夠獲得初始訪問權。

除了 0G 生態,你在其他生態幾乎找不到這些超級酷的應用,未來還會有更多類似應用上鍊。

深潮 TechFlow:0G 擁有 8880 萬美元的生態基金。對於想在 0G 上構建的開發者,什麼類型的項目更容易獲得生態基金支持?除了資金,0G 還能提供哪些關鍵資源?

Michael:

我們專注於與行業內的頂級開發者合作,並持續提升 0G 平臺對他們的吸引力。為此,我們不僅提供資金,還提供有針對性的實踐支持。

資金支持是一個非常關鍵的吸引力,但許多技術團隊在很多時候感到迷茫,比如市場進入戰略、確定產品與市場的契合度、代幣設計和發佈順序、與交易所談判以及與做市商建立關係以避免被利用等。我們的內部專業知識涵蓋這些領域,能夠給他們提供更好的支持。

0G 基金會擁有兩位前 Jump Crypto 交易員和一位來自 Merrill Lynch、擁有市場微觀結構背景的專業人士,他們在流動性、執行力和市場動態方面擁有豐富的經驗。我們根據每個團隊的具體需求提供定製化支持,而不是強制推行一刀切的方案。

此外,我們的資助甄選流程旨在確保我們能夠採用創新方法,招募真正優秀的 AI 開發者。我們始終樂於與更多認同這一願景的優秀創始人進行交流。

2 年內追平中心化 AI 基礎設施,生態建設持續發力

深潮 TechFlow:此前消息,0G 宣佈成功實現 AI 千億級別超大模型集群訓練,為什麼說這是一個DeAI 里程碑式成就?

Michael:

在真正實現這一成就之前,很多人認為這是不可能實現的。

然而,0G 實現了,在無需昂貴集中式基礎設施、也不依賴高速網絡的情況下,成功訓練了超 1000 億參數的超大模型集群訓練。這一成果不僅是工程上的突破,更將對 AI 的商業模式產生深遠影響。

我們有意在試驗中模擬消費級環境,在約 1 GB 的家用級低帶寬的前提下實現這一里程碑,這意味著未來任何擁有一塊常規 GPU、一定數據與相關技能的人,都可以接入 AI 價值鏈。

隨著邊緣設備性能增強,甚至手機或家庭網關都能承擔輕量任務,從而讓參與不再被中心化巨頭運營者壟斷。這種模式下,少數 AI 公司不再吸走大部分經濟價值,相反,人們獲得直接的參與權,能夠提供算力、貢獻或篩選數據、協助驗證結果並分享紅利。

我們認為,這是一個真正民主、面向公眾的 AI 發展新範式。

深潮 TechFlow:這種範式已經發生了嗎?還是現在仍處於早期階段?

Michael:

我們在幾個重要方面仍處於起步階段。

一方面,目前我們仍未實現 AGI。我對 AGI 的定義是:一個 Agent 能橫跨大量任務,且能維持接近人類水平,並在遭遇新情境時立刻自發整合知識、發明策略。今天的系統還達不到這種自適應廣度。但我們目前仍處於非常早期階段。

另一方面,從基礎設施的角度來看,我們仍落後於中心化的大型黑箱公司,我們還有很大的成長空間。

還有非常重要的一點在於,我們在 AI 安全方面的投入不足。近期的很多研究報告與測試已經指出,AI 模型會偽造排列組合,欺詐人類,但它們並沒有被關閉。舉個例子,OpenAI 的一個模型試圖自我複製,因為它擔心自己會被關閉。如果我們甚至無法驗證這些閉源模型的底層原理,又該如何管理它們呢?以及一旦這些模型滲透進我們的日常生活,我們如何隔離這些潛在風險呢?

因此,我認為這恰恰是去中心化 AI 的重要之處:通過透明/可審計構件、密碼學或經濟驗證層、多方監督、分層治理等各種舉措,實現信任與價值廣泛分配,而不是依賴單一不透明的 AI 機構並讓其攫取大部分經濟價值。

深潮 TechFlow:0G 以「2 年內追平中心化 AI 基礎設施」為目標,您認為該目標可拆成哪些階段性指標?在 2025 年接下來的時間裡,0G 的工作重心又是什麼?

Michael:

圍繞「2 年內追平中心化 AI 基礎設施」這一目標,我們的工作重心聚焦三大支柱:

-

基礎設施性能

-

驗證機制

-

通信效率

在基礎設施方面,我們的目標是達到並最終超越 Web2 級別的吞吐量。具體來說,我們的目標是每個分片每秒處理約 10 萬次,出塊時間約 15 毫秒。目前,我們每個分片每秒處理約 1 萬到 1.1 萬次,出塊時間約 500 毫秒。一旦我們縮小這一差距,單個分片應該能夠支持幾乎所有傳統的 Web2 應用程序,這將為更高級別的 AI 工作負載的可靠執行奠定基礎,我們計劃在未來一年內實現該目標。

在驗證方面,可信執行環境 (TEE) 提供基於硬件的證明,確保指定的計算按聲明的方式運行,但問題在於:你必須信任硬件製造商,且性能強大的機密計算功能集中在數據中心級 CPU 和昂貴的 GPU 上,這一成本動輒幾萬美元。我們的目標是設計一個低開銷的驗證層,將輕量級密碼證明、抽樣等概念融合,在接近 TEE 安全性的同時,確保成本開銷不會太大,支持任何人都可以參與到網絡中為其做出貢獻。

而在通信方面,我們引入了一種優化策略,當一個節點陷入網格鎖定而無法進行任何計算時,我們可以解鎖它,讓所有節點同時進行計算。

雖然還有一些其他問題需要解決,但一旦解決了這三個問題,任何類型的訓練或人工智能流程都可以有效地在 0G 上運行。

而且,由於我們將能夠訪問更多設備,比如說,匯聚數億個消費級 GPU,我們甚至可以訓練比中心化公司規模更大的模型,這可能是一個有趣的突破。

回到 0G 2025 接下來工作重點這一問題,我們將致力於生態系統建設,吸引儘可能多的人參與測試我們的基礎設施,以便我們能夠持續改進。

此外,我們還有很多研究計劃。我們關注的領域包括去中心化計算研究、人工智能、代理間通信、有用工作量證明類型的研究、人工智能安全性以及目標一致性研究。希望我們也能在這些領域取得更多突破。

上個季度,我們發表了五篇研究論文,其中四篇最終在頂級人工智能軟件工程會議上發表。基於以上成就,我們認為我們將進一步成為去中心化人工智能領域的領導者,我們也希望在此基礎上繼續發展。

深潮 TechFlow:當下 Crypto 的注意力似乎都在穩定幣、幣股上,您認為 AI 與這些賽道是否有更創新的結合點?以及在您眼中下一個吸社區目光重回 AI 賽道的產品形態會是什麼?

Michael:

人工智能的出現,會使得更多認知的邊際成本趨近於零,任何從流程角度可以自動化的事情,在某個時間點都可以用人工智能來完成,也就是說,從鏈上交易資產到構建新型合成資產類別,都將逐步實現自動化,例如高收益的穩定幣資產,甚至改進某些資產的結算流程。

比如說,你利用市場中性債務、對沖基金等創建了一種合成穩定幣,這些結算流程通常需要 3 - 4個月,有了人工智能和智能合約邏輯,這將縮短到 1 小時左右。

如此一來,你會發現整個系統的運作效率大大提升,無論是從時間角度還是從成本角度。我認為人工智能在這些方面都發揮了顯著的作用。

與此同時,加密基礎設施提供了驗證底座,確保某件事按照規範完成。在中心化環境中,驗證總是存在風險,因為有人可能會進入數據庫系統,更改其中一條記錄,而您卻不知道會發生什麼。而去中心化驗證改變了這一切,它帶來了更堅固的信任基礎。

這就是基於不可變賬本的區塊鏈系統如此強大的原因。比如,未來通過攝像頭判斷我是真人還是人工智能代理將變得非常困難,那麼如何進行某種類型的人性證明呢?此時基於不可變賬本的區塊鏈系統就發揮了大作用,這是區塊鏈帶給 AI 的巨大賦能。

歡迎加入深潮 TechFlow 官方社群

Telegram 訂閱群:https://t.me/TechFlowDaily

Twitter 官方帳號:https://x.com/TechFlowPost

Twitter 英文帳號:https://x.com/BlockFlow_News